以前、映画『2001年宇宙の旅』の続編『2010年』の記事で、同作が人工知能を冷静に描いているところに好感を持ったと書きました。今回はあらためて、人工知能(AI)について「今すぐ対応が必要な問題点」と「全然心配いらないこと」が具体的にどのようなことなのかを扱います。

私はもともとデジタル関係が好きなのですが、だからこそ最近AIがセンセーショナルに取り上げられがちなのを気にしています。熱い頭で現実を見誤るのを防ぐため、私は「人工知能」という名称をできる限り避け、適宜「プログラム」「ソフトウェア」「機械」といった「夢のない」呼び方をしたいと思います。

(最新:ChatGPT、GoogleのBardなど生成AIについては、この記事中に解説を入れると長くなりすぎ、目当ての項目が見つかりにくくなるので、別途新たに記事を書き下ろしました。以下リンクから参照してください。)

関連リンク:生成AIとは?―どこが問題点で、何が起こっているのか

目次

前提―人工知能の定義

人工知能(Artificial Intelligence, AI)の研究が目指すのは「人間の知能を機械で再現すること」です。こういったプログラムの研究は20世紀中頃に始まり、何度かのブームと挫折を繰り返した後、コンピューターの性能向上とインターネットの登場によって近年飛躍的に発展しました。しかしこれだけ使われている言葉であるにもかかわらず、そのはっきりした定義はありません。

AIといえばだいたいは「人間のような知能があるように見えるプログラム」を指していますが、この範囲は広く、またあいまいです。「人工知能とは何か」自体が今日でも議論されているところであり、定義は研究者によってまちまちです(『人工知能は人間を超えるか ディープラーニングの先にあるもの』45頁参照)。あとでじっくり述べますが、こんなあいまいな定義だからこそ、宣伝文句に登場させやすいわけです。

AIという言葉の響きからは、いかにも未来的な人型ロボットを想像したかもしれません。あるいは、メディアで耳にはさんだ「人類を滅ぼす恐怖のマシン」に不安になったという人もいるのでしょう。しかし実際には、その定義に当てはまるソフトや機械の機能は、もうずいぶん前から、私たちの日常のあちらこちらに点在しています。たとえば、

- ショッピングサイトでおすすめ商品を表示するプログラム

- デジカメの顔認識やオートフォーカス機能

- ゲームの敵キャラクターの動き

- パソコンやスマホの顔認証

- カメラで書類を撮影して文字におこすアプリ

- SNSでセンシティブな画像を自動で判別して注意書きを表示するプログラム

など、私たちがごく日常的に触れてきたプログラムが、最近では「人工知能/AI」と呼ばれる(あるいは、メーカーや運営者がそう呼びたがる)ことが増えました。

このように定義はあいまいだということを常に念頭に置きつつ、本稿では「人間のような知能があるように見えるプログラム」について論じていきます。

AIの問題点・デメリット5選―今すぐ対応が必要なこと

現実に立脚して言えば、私たちの生活に入ってくる人工知能といえば、まずは作業を自動化するソフトや機械になるでしょう。近年開発が進んでブームとなった類のものは、未来予測や異常の検知にも長けています。こうしたプログラムの研究開発では、大量のデータを読み込ませて「学習させる」という方法がとられます。

しかし世の中、すべて特徴は長所にも短所にもなって表れます。人々の生活を便利にする作業自動化や予測、異常検知などは、デメリットにも転じるのです。既存のデータから「学習させる」という独特な開発方法も然り。以下では、人工知能の特性がデメリットとして表面化する場面をみていくことにします。

差別―「AIがした差別」の全責任は、人間

人工知能は、人類とは異なる視点を持った新しい知的存在なのか――未知なる存在との出会いに胸躍らせるのはSFのだいごみですが、現実を学ぶときには頭を切り替えなければなりません。

まずは「AIが差別をした」事例を紹介し、その考察や私見などを述べていこうと思います。

アメリカの裁判所で「人種差別ロボット」が登場

2016年5月、アメリカで、コンパス(Correctional Offender Management Profiling for Alernative Sanctions: COMPAS)というソフトウェアが、黒人の再犯率を高く見積もったことが報告されました。白人の再犯率24%に対して黒人は45%と、2倍近くにのぼります。同ソフトウェアは、アメリカの何百もの裁判所で使用されています。

COMPASを制作したのはNorthpointeという私企業で、黒人の再犯率を高く見積もっていはいないと反論しました。しかし企業の利益を損なう可能性があるとして、結果を算出したアルゴリズムは明かしませんでした。

「ゴミをつめれば、ゴミを吐き出す」

この事件を報じたガーディアン紙が引いているのが、「ゴミをつめれば、ゴミを吐き出す(Garbage in, garbage out.)」というコンピューター工学の格言です。人間がろくでもないプログラムやデータを入れればコンピューターはそれをするようになる、という意味です。

人工知能が広く知られるようになるにつれ、「人間は差別をするけれど、コンピューターなら偏見や先入観を持たないのではないか」と期待する向きが出てきています。なくそうとしてもなかなかなくならない差別を解消してくれるのでは、というのです。しかし残念ながら、それは夢物語にすぎません。

偏見を持たない人工知能は、事実上存在し得ない。なぜなら、それに取り込ませるデータのソース(出所)が、他でもない人間社会だからです。別の角度で見ると、「データとは偏見・差別の結果を集積したものだ」といっていいでしょう。たとえばほんの一例ですが、今日の世界で「グローバル企業の社長はどのような人か」といったら、人種や性別には偏りが出ますよね。データを取り込んだ瞬間、AIは人間社会を反映します。差別が蒸し返される可能性ならあっても、画期的なことは何も起こりません。

植民地主義による被征服文化・民族、また特定の人種・性別などによる被差別属性には、「本来の姿」がすでに不明になっているという深刻な問題があります。たとえば、旧植民地のアフリカ系の人々は現在、旧宗主国の言語をしゃべり、名前を持ち、文化に染まり、植民地時代からの歴史的連続性のなかに生きている。「もとの文化」は、もうない。もしも差別がなかったとしたら、その人はどんな性格で、どれほどの能力を持ち、どのような立場でどういう人生を送り得たのか。言い換えると、過去の植民地政策の影響が及んでいるという条件を取っ払った「本来の自分」はどんなものなのか。こういったアイデンティティ・クライシスは、緊張感のある、緻密な思考が求められる課題です。

差別の本質的害悪は、差別される人の尊厳をすり減らしてしまうことにあります。異なる者に平等を、制度に公平さを求める気持ちは、人間として極めて正当かつ自然です。

ただ、中立性や公平さ、あるいは「本来の姿」を見て(あるいは見つけて)もらうことを新しいコンピュータープログラムに期待するなら、それは的外れと言わざるを得ません。AIは、客観的な視座に立つ新しい第三者ではないからです。

人間は差別をするから問題だ、というなら、人間が差別をやめる以外に解決策はないのです。未知なる存在が空からやってきて願いを叶えてくれる、なんていうことはありません。

差別は新しいコンピュータープログラムうんぬんではなく、純粋に人間の問題です。たとえ歩みはのろくとも、一歩一歩努力を重ねて、差別をなくしていくことが必要です。

どんな道具を使っていようが、差別は行為者の責任

コンピュータープログラムの関わる差別は、企業の採用の場面などでも問題になります。ソフトウェアが過去のデータに基づいて「見込みのある候補者」を抽出したら、特定の人種、性別、健康状態などの人が自動的にはじかれた、といった事例です。

作業の自動化は、差別の言い訳になりません。なぜなら、行為主体はあくまで当該業務を行った人間だからです。

たとえば、企業の採用担当者がどんなボールペンでメモをとっていようが、差別をしたならその人の行為ですよね。ボールペンのせいではありません。採用担当者がどんなモデルのパソコンを使っていたかも一切関係ありません。

同じく、どんなAIを使っていようが、差別をしたのはその人です。差別の全責任は、当該行為をした人間にあります。

コンピュータープログラムの利用が差別の問題を複雑化し、わかりにくく、反論しにくく、不透明にすることはあるかもしれません。しかし冷静に考えれば、事実は案外シンプルです。

冤罪―すでに起こりました

無実の人が犯人と間違われ、ある日突然「犯罪者」にされてしまう――「足利事件」などでよく知られる「えん罪」は、私たちの社会でもっとも忌まわしいことの一つです。

AIを使って犯罪の予測をする、という提案や実験が出てきています。犯罪が起こりやすい場所をデータからはじき出したり、防犯カメラの映像から不審な動きをしている人物を見つけたりできるというのです。

しかし、これによって冤罪の危険性はないのか? 実は、未来に起こるかもしれない、ではなく、すでに起こりました。

FBIの顔認識ソフトで強盗犯と間違われ、逮捕された

2014年、金融ブローカーのスティーブン・タリーさんが住むアメリカのデンバーという町で、銀行強盗事件がありました。犯人は逃走。そんなある夜、タリーさんは自宅でごく普通の一日を終えようとしていたところ、ドアのベルが鳴り、開けた瞬間、彼は軍人のような男数名に襲われました。「強盗だ、殺される!」……と思ったら、彼らはFBI捜査官だった。タリーさんは逮捕されました。警察に、「防犯カメラに映った銀行強盗と似た人を知っている」というタレコミがあったからでした。

何か月も拘留されたのち、タリーさんは事件の日時に職場にいたと、アリバイを証明することができました。さんざんな目に遭いましたが彼は釈放され、日常生活に戻りました。

ところがこの一年後、彼は再び逮捕されました。FBIの顔認識ソフトウェア(つまりAI)が、ビデオに映った強盗犯と、おそらく1回目の逮捕で警察が撮ったのであろうタリーさんの顔写真が同一人物だという分析結果を出したからでした。

たまたま強盗犯と顔が似ていたために、ついにはホームレス

2回目の逮捕後も、彼は無事釈放されました。

しかし冤罪により、彼の人生はどうなったか。金融ブローカーだったタリーさんは職を失い、ついにはホームレスになってしまいました。

当然ですが彼は訴訟を起こし、1000万ドルの損害賠償を求めて係争中だということです。

人間によるチェックもあったのに、この結果

いま、オフィスでは手書き文字や書類をデータに起こすソフトの活用がしだいに広がってきています。こうしたソフトが念頭に置かれると、一般には「AIだけでは融通が利かないので、人によるチェックも必要だ」といわれます。

ところが本件では、人間――しかも、FBIで顔の分析に関する特別な訓練を受けていた捜査チーム――による十分なチェックがあり、プロ中のプロが間違いないと太鼓判を押したにもかかわらず、結果は人違いでした。それどころか、顔認識ソフトウェアが出した分析結果は、捜査官の「タリーさんが犯人で間違いない」という思い込みを強化してしまった。

本件により、「人のチェックで補足すればプログラムによる判断は完全になる」わけではないことが浮き彫りになったといえるでしょう。AIに半ば依存する捜査手法と心理が冤罪を生んだと考えられます。人間は間違いますが、コンピューターだって間違う。また、コンピューターは間違うけれど、人間もまた間違うのです。

機械には、絶対に依存するな

警察は、最も強力で恐ろしい国家権力です。国家に必ず必要な力である一方、ひとたび犯罪捜査にかかれば、対象となった市民の権利を著しく侵害するからです。警察官がドアをけ破る、家宅捜索に入る、押し入れの中身を全部調べる、通帳を押収する、身柄を拘束する、などを想像してみればいいでしょう。その危険性ゆえ、憲法33、34、35条がそれぞれ逮捕、抑留・拘禁、住居および所持品への侵入・捜索・押収に条件を課して歯止めをかけ、刑事訴訟法という大法典が作られているくらいです。

その重みがある犯罪捜査の場面で、データ分析をAI(=機械)に委託するなどという軽はずみなことがあってはなりません。

ちょっとしたしぐさや行動がたまたまプログラムに「不審者らしい」と判定された。あるいは、犯罪の被疑者と偶然顔が似ていた。そんなことからある日突然転落人生に陥る人は必ず出てくる……ではなく、すでに出ました。

ただその割に、私は人工知能の使用による冤罪への危機意識は低いなと感じています。

治安という意味での「安全」と、私たちに降りかかる冤罪(と後に述べるプライバシー侵害)からの「自由」は、どちらかに重きを置けばどちらかが軽くならざるを得ない関係にあります。犯罪捜査や防犯に関わるなら、この世の法則は必ず頭に置かなければなりません。新しいテクノロジーの研究者なら、他分野の専門家とも積極的に意見交換や協力をしていくべきでしょう。

同時に、犯罪捜査や防犯関連事業にたずさわる者は、必ず考えなければなりません。仮に機械の判断をもとに嫌疑をかけ、無実の人に濡れ衣を着せてしまったら、その後一体どんなことになるのか。自分が破壊した冤罪被害者の人生をどう背負い、つぐなっていくのか。警察や企業の法的責任はいかなるものか。国家権力たる警察なら、えん罪被害者に与える損害ははなはだしいものとなります。国家賠償責任が生じるのはもちろん、歴史に残る汚点となるでしょう。私企業であっても、莫大な損害賠償責任が生じる上、会社の信用は失墜、社会からの批判もただではすみません。早い話、不祥事のなかでも重大な不祥事です。謝ってすむ問題ではありません。それを押してまで「そんなもの」に寄りかかりたい人なんていませんよね。

世論の誘導―人々の心理を裏から操作

テクノロジーと名のつくものには、必ず、悪用する方法があるものです。そして近年発達したコンピュータープログラムには、「世論の誘導」という悪用法がある。そしてその悪用は、一部ですでに起こりました。

以下で紹介していく事例には、プログラムの制作者や使用者に悪意はなかった、というケースもあります。しかしそれでも、予想もしなかった使用法や過失によって生じる被害の甚大さ、そして時間を追うごとに生じてくる不気味な現象は、デジタル時代を生きる上で誰しもしっかり頭に置いたほうがいいでしょう。

政治:ボット(Bot)を使って人の心理を遠隔操作、選挙結果を誘導した事例

Twitterなどで、 bot(ボット)という言葉を耳にしたことはあるでしょうか。ボットとは、主にインターネット上でタスクを自動で行うプログラムのことです。実は、いまやインターネット上で活動している主体(?)の半数以上はボットだといいます。人間のように見える以上、ボットも一種のAIといえるでしょう。

ツイッター用のボットができることといえば、毎朝7時に「おはようございます」とツイートする、きれいな画像を自動でリツイートする、映画の名ゼリフを一日三回投稿する、など。きわめて無害で、便利だったりおもしろかったりするものですね。

しかし、悪意を持った人間なら、ボットにどのような活用法を見出すのでしょうか。

2017年12月、トランプ政権下のアメリカ連邦通信委員会(FCC)で、ネットワーク中立性(Net Neutrality)撤廃の議決がなされました。これは、かんたんに説明すると、各国政府はインターネット上のあらゆる情報に対して中立の立場をとっているところ、FCCがインターネットプロバイダー(「○○光」のような業者や携帯電話会社)に新たなビジネスチャンスを提供するため(たとえば、インターネットプロバイダーが、自分に金を払ってくれた企業等のサイトはつながりやすく、払わなかったサイトのロードはひどく遅くする、など)、このルールを撤廃した、という事件です。

この、自由で開かれたインターネットが存続するか否かという重要な投票に、ボットが影響したというのです。投票前、連邦通信委員会のサイトには、ボットが何百万にも及ぶコメントを自動で投稿しました。投稿者にはルーク・スカイウォーカー(映画『スター・ウォーズ』の主人公)という名前まであったというのだから馬鹿げています。しかしこの結果、ネットワーク中立性撤廃の議決がなされ、アメリカでは現に、インターネット上での自由が著しく制限されることとなりました。一般人への影響は甚大です。笑い事では済まされません。

自動化プログラムであるボットの裏には、それを使用した誰かがいることを忘れてはなりません。これは言い換えれば、ボットを使った人間が人々を意のままに誘導した、ということを意味するのです。

ボット(AI)が自動投稿した文に人間が踊らされ、政治が動いた――それが現実に起こる時代です。これはもちろん、アメリカに限ったことではありません。

ネットの情報は、全体として質が悪すぎるといいます。無数の人がいいかげんな情報やデマを流していることはもちろんですが、ボットもその一因です。ネットで見つけた目玉情報、最新情報……本当は、ボットが自動生成、自動投稿した文にすぎないかもしれません。そしてボットの背後には、必ず誰か、人間がいます。おそらくは、悪意のある……。念を押しておきますが、踊らされている人に、踊らされている自覚はありません。

ネット上の議論(?)や誰かのブログのコメント欄を見て自分の投票先を決めた。とあるツイートに共感した。次で紹介するような、「あなたへのおすすめツイート」を参考にしている。……それは、本当に、あなたの意見ですか?

関連記事:インターネットからの個人情報流出事件解説と、自分でできる対策

購買:「おすすめ」の連鎖が生む、世にも不気味な現象

ショッピング系サイトには必ず出てくる「こちらの商品もおすすめ」「これを買った人はこちらも見ています」「あなたへのおすすめ」――このような、個人の閲覧履歴、買い物履歴、また全ユーザーの行動パターンから一人ひとりへの「おすすめ」をはじき出して表示するプログラムは、最近では「人工知能」と呼ばれ得るものの代表格となっています。もっとも「おすすめ」表示ならオンラインショップの黎明期からずっとあったわけですが、プログラムの開発が進んだり、AIが一種のブームになったりしたことで、最近呼び名が変わった、という感じでしょうか。

しかしこの「おすすめ」プログラム、何度も何度もくりかえしていくと、世にも不気味なことが起こってくるのです。

きっかけは、ほんのささいな検索です。たとえばモデルケースはこんな感じ。――健康体操の本が世間で話題になっているけど、どんなものなんだろう。お風呂の後に、たまたまちょっくら検索してみた。そうしたら商品ページの下のほうに、ダイエット関係の本が載っていた。おもしろそうだな、と思ってそちらの商品ページを見ていたら、「この商品を見た人はこちらも見ています」と、コレステロールを下げるサプリメントが出てきた。そうそう、コレステロールが気になってるんだった! すぐさまクリックして、流行りの健康体操本といっしょにカートへ入れ、そのままレジへ。数日後、ショップから「あなたへのおすすめ」メールが届いた。載っていたのは「メタボは気にしなくていい」という趣旨の本と、育毛剤と、幼児向け知育玩具と、「副業でお金持ちになることは誰にでもできる」というビジネス書。副業か、いいな、やってみたいな。――

……どこまでが自分の意志だったと断言できますか?

このように、「おすすめプログラム(=AI)」の連鎖によって自分の欲しいものが決まってしまう、自分の価値観さえも流されていってしまう、という世にも不気味な現象がいま起こってきています。

コンピュータープログラムによる「おすすめ」は、検索ワードの履歴、閲覧した商品の履歴、そのアカウントで買ったものの履歴、そして他の人の行動履歴をもとに算出されています。

上の例だったら、過去に、ダイエット本を閲覧・購入した誰かがコレステロールサプリにも興味を示したケースがあったのでしょう。買った物の性質によっては、プログラム側はユーザーの年齢や性別、職業などを推測できます。その属性データが加わると、「コレステロール」と「副業」など、最初の検索とはまったく関係ない事柄が次々と、プログラムによってドッキングされていきます。さらに、あなたの行動は次のおすすめをつくる基礎データとなるので、今度は見も知らぬ誰かのところで、コレステロールサプリと副業本がいっしょにおすすめされている。さて、その人は、コレステロールを下げることと副業を始めることを望んでいたでしょうか?

このように「おすすめ」が暴走していくことで、「主体」の存在を欠いたまま、世の中規模で「人間の行動パターン」が形成されていきかねないのです。もっとも、裏から見えない糸を引いて世の人々に「欲しい!」を生じさせる心理誘導はとうの昔からあるのですが(代表例といえば「マイホーム神話」)、「おすすめ」プログラムの暴走には一部、新しい問題点が含まれているわけです。

こうした心理誘導は、プラットフォーマー(出店形式の大手ショッピングサイト)、あるいは歴史上の独裁者のごとき悪に精通した人間の目にはどう映るのでしょうか。自分の所有物であるおすすめプログラムにほんの少し細工をして、自分が望む通りに、人々を特定の商品や考えに誘導していく――それは技術的に可能です。

あなたが欲しいと思っているもの、それは本当にあなたの意思ですか?

関連記事:心理誘導の今昔:人の欲望は、作り出せる

陰謀論:ごく普通だった人が豹変する、突然の悪夢

根拠なき陰謀論の広がりと、その支持者による凶行。ごく普通だった知人や家族があれよあれよという間に変貌し、たった数ヶ月で社会生活が成り立たなくなる突然の悪夢。陰謀論はいま、日本を含め世界中で大きな社会問題となっています。

問題となった陰謀論には、たとえば次のようなものがあります。

- 米トランプ氏は、政財界やマスコミに巣くう悪人と秘密の戦争を繰り広げている(「Qアノン」の陰謀論。2021年、バイデン新大統領就任にあたって支持者らが議事堂を襲撃した事件は世界を震撼させた)

- 新型コロナウイルスのワクチンにはマイクロチップが入っている

- 政府や宗教団体が、特殊な兵器で市民を遠隔攻撃している(これは筆者が目撃した例。後述します)

……突拍子もない話ばかりですよね。もちろん、どれにも根拠はありません。それなのになぜ、こんなに大勢の人が陰謀論を信じてしまうのでしょうか。

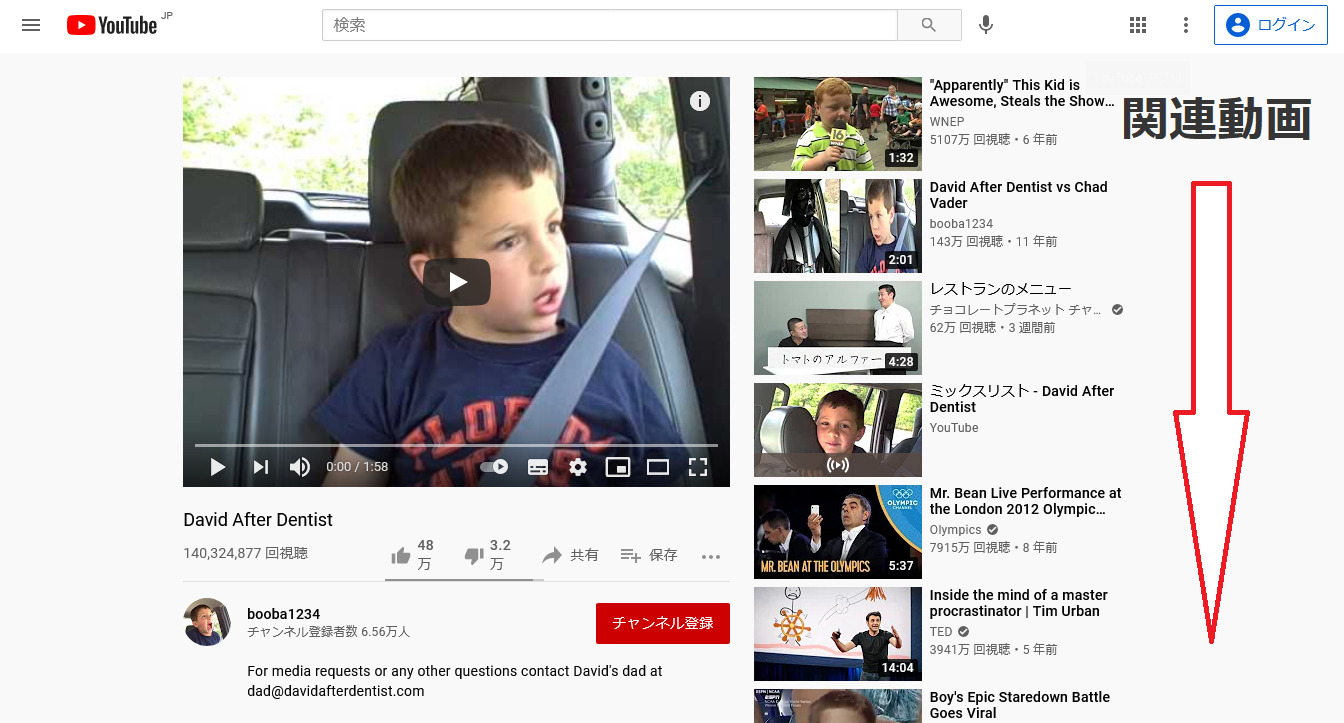

陰謀論が信じられる大きな原因となっているのが、AIによって表示されるSNSの「おすすめ」投稿、とくにYouTubeの自動再生です。「あなたへのおすすめ」とか「あなたと同じ興味関心のユーザーはこちらも見ています」などとして似たような動画や投稿が出てくるあれです。

こうした「おすすめ」が、陰謀論とどう関係しているのでしょうか?

事の始まりは、たった一本の動画です。知人から教えてもらったとか、何かを検索した際に出てきた、SNSのタイムラインに流れてきたなど、きっかけは誰にでもあるささいなこと。なにも最初から陰謀論に興味を持って検索したとは限らないのです。

本稿の上でなら引いた眼で見られるので、馬鹿げているといとも簡単に見破れるかもしれません。しかし、陰謀論の動画や投稿はじつにもっともらしく、よくできています。というのも、私は以前、Twitterでとある陰謀論のYouTube動画に出くわしたことがあるのです。その内容は、現実にあり得ないような「兵器」が存在していて、政府や諸団体が人を遠隔で攻撃、洗脳している、というもの。……ひどい被害妄想だと思ったかもしれませんが、元イギリス諜報機関職員と名乗る男性が(スクリーンのこちらからでは経歴が本当かどうかは不明)、黒いスーツでビシッと決め、専門用語をいろいろ織り交ぜ、「自分が携わっていたこと」「政府が実際にやっていること」などと「体験談」をまじえながら、「自分は本当のことを伝えているから敵視されるのだ」と主張し(多くの陰謀論に共通する特徴で、「この説だけが正しくて世間が間違っているんだ」と信じ込む原因になる)、1時間以上かけてこまごまと熱心に解説するその動画は実にもっともらしかったので、私は背筋が凍ったのを覚えています。

このような動画や投稿を一本見ると、SNSの「おすすめ」プログラムは、同じ陰謀論の投稿や動画を次々と「おすすめ」したり、自動的に再生します。するとどうでしょう。あの人もこの人もこう言っている。それが正しいのだと、一気にのめりこんでいってしまうのです。

視聴中の動画や閲覧履歴をもとにしたAIの「おすすめ」では、同じような動画ばかりが出てきます。一般社会全体をみれば陰謀論への反対意見が山ほど存在しているのですが、そちらはほぼ出てきません。しかも陰謀論動画を視聴した履歴が一つ、また一つと積み重なっていけば、「おすすめ」はどんどん加速します。なので、陰謀論が実際よりも影響力のある見解に見えてしまう。まるで世界の全てであるかのような錯覚に陥ってしまうのです。

この状況、家族や友人などにしてみればどうでしょう? 陰謀論にのめりこんだ人は突拍子もないことを夢中になって周りに押し付けるのだから、人間関係や社会生活には支障が出てきます。「まだ知らない人に本当のことを教える」活動がいそがしくなり、仕事ができなくなった。職場で同僚との関係がこじれ、退職することになった。家庭で言い争いが増え、いっしょに暮せなくなった家族が離婚や別居をせざるを得なくなった。なかには、陰謀論を支持する団体に財産をなげうった、などという事例も聞かれます。

しかも、こうして社会生活を営むことができない状態になるまでのスピードは信じられないほど速いです。私が聞き及んだ事例では、たいていたったの数ヶ月。家庭が崩壊したある事例でも、平穏だった夫婦が離婚に至るまで一年かかっていません。その様子を間近で見ていた家族が「突然の悪夢」などと証言する通りです。

こんな話を聞いたら、読者は「そんな錯覚に陥るのは心の弱い人ではないか」などと思ったかもしれません。妄想が出る病気を疑ったかもしれません。しかし、こうして陰謀論にのめりこんでいった人のほとんどは、健康なごく普通の人です。高い学識を持つ人も含まれています。

似たコンテンツをはじき出して表示するAIが原因となった、思いもかけない悪夢。現代ネット社会を生きる我々は、世の中にはそういう現象があるのだ、心が弱いからなどではなく誰にでも起こり得るのだ、と知っておくべきでしょう。言ってしまえば、新手の詐欺のようなもの。「息子や警察官を名乗る電話でキャッシュカードを求められたらオレオレ詐欺だ」とあらかじめ知恵をつけておくのが防犯や早期対応につながるのと同じです。

特に問題視されているYouTubeの自動再生は、オフにすることが可能です。頭を冷やす時間的余裕ができるでしょう。

とはいえ、陰謀論は、考え出したのも、動画を撮影したのも、夢中でネットに投稿したのも、みなあくまで人間です。人工知能に「遠隔で洗脳」されたわけではありません。「おすすめ」プログラムは原因の一つにすぎないのです。

陰謀論から覚めた多くの人は、「はまっていた時は、自分が見たいものを見ようとしていた」と語っています。あなたが信じる「おもしろい」陰謀セオリーは、現実ではなく、「自分が見たいもの」ではありませんか?

<関連記事>

『Qアノンの正体』徹底解説(ネタバレ有)~混乱はどこから生まれ、どう展開したのか

裏には必ず、誰か人間がいる

以上のように、ネット上のコンピュータープログラムによって政治的意見や購買意欲、価値観のかつてない誘導が可能になるなか、「自分の頭で考える」習慣は今あらためて大事になっています。自分で主体的に判断することができず、他の人がどうしているかをいちいち気にしたり、周りにずるずる流されたりしていれば、いつしかボットやおすすめプログラムに……ではなく、それを使用している人間にまんまと心理を誘導され、「自分」というものまで失ってしまいかねません。

ボットに関して言うなら、現段階では、ボットが生成した文はぱっと見だけで判別できることが多いです。たとえば、迷惑メールで「あなたがが」などと明らかに不自然だったり、意味が通らなかったりする文を見たことはありませんか? あれはボットにより生成、自動送信されたものです。ランダムなメールアドレスも、たいていボットです。しかし今後、人間と見分けがつかないほどの文を生成・投稿するボットが増える可能性はあります。

人々の心理を、見えない糸を引いて操る――。AIと呼ばれるコンピュータープログラムを利用した「世論の操作」は、目に見えにくく、不気味で、恐ろしく、とりわけ政治的意思決定の誘導となれば私たちの国家や社会、個人の実生活へのダメージが深刻です。しかしここまで読んでくればもうお分かりですね。これをやっているのはすべて、人間です。

政治ボットの危険性は、国際的に議論になっています。国によっては、すでに法律による規制ができてきます。

プライバシー―機械は忘れない

人の記憶からは、多くのことがぼろぼろとこぼれ落ちていきます。あの人がいつ何と言ったか。あそこへ行ったのはいつだったか。我々人間は、自分が見聞きしたほとんどの出来事を思い出すことができません。

しかし、機械は違います。ひとたびメモリーに入ったことは、物理的な破損でもない限りいつまででも覚えています。たとえば一か月前の今日の今の時間、あなたはどこで何をしていましたか? ……答えられるはずがないでしょうが、機械なら、正確な緯度・経度、秒単位まで正確な時間、買った物すべての正確な商品名や個数まで、知ったら最後、全部忘れることがありません。

プライバシーというと、意味がよくわからずにいる人や、極端な話のように受け取る人が日本にはまだずいぶんいるようです。「自分のデータ? 別に使ってくれていいよ」とか「そんな隠さないでもいいじゃん」「隠すことなんてないよ」くらいに思っている人もいるとか。……甘すぎです。

あとで取り返しのつかないことにならないよう、「この世で最も悪い人間ならどうするか」を常に考えることが大切です。いつの時代も悪人は、ただでなく頭がいいのですから。

急成長をとげる「データ分析産業」の内情

さて、「データ取引」というのを聞いたことがあるでしょうか。これは、犯罪としての個人情報売買のことではありません。正当なビジネスとして、今、データの売買は急成長しています。最近は「データサイエンス」がメディアですばらしいもののように取り上げられることが増えましたが、依頼者のためにデータに基づいて予測やアドバイスを行うサービスはまさにデータ売買の一形態です。

データ分析会社には、あちらこちらから売られてきたデータ(たとえば顧客情報など)が集まります。それらの断片がどこかでつながってしまったら最後、あなたの氏名、住所、電話番号、メールアドレス、家族構成から、毎日の行動パターン、通った道路と正確な時間、学校や職場の正確な情報、事細かな趣味・嗜好まで、まるごと分かってしまうことが指摘されています。あなたに関する、生涯の大親友や配偶者でも知りえないほど細かで莫大な情報を、見も知らぬデータ分析会社が勝手に閲覧・分析している(ここでAIが使われる)。そして分析結果をまとめ直し、別の誰かに売りさばいている。それが現実に起こっている時代です。この産業には、データ売買専門の会社もあれば、GoogleやFacebook、Yahooなどのように社内で行っている場合もあります。

では、なぜ企業はそんな悪趣味きわまりない取引をしたいのか? 理由はいたって単純で、金になるからです。データ取引産業はこれを「ビッグデータの活用」とか「21世紀の資源」などと呼びますが、「データマイニング」で掘られるのは鉱山の石炭でも海底の石油でもなく私たち人間なのですからたまったものではありません。さらに、データが悪意ある者の手に渡れば、恐ろしい犯罪などに利用されることが予測されます。

データ取引は、生身の個人にとって気持ち悪いのは言わずもがな、多大な危険性をはらんでいるのです。

それを象徴するのが、米トランプ大統領です。データ分析会社がFacebookから流出したデータを利用してアメリカ大統領選の結果を動かしたとみられるSNS史上最悪な事件について、以下の記事で徹底解説しました。とても重要な補足なので、併せてお読みください。

関連記事:FacebookからCambridge Analyticaへの個人情報流出事件を徹底解説!

個人情報の分析や売買を危惧する人や団体は、たくさん出てきています。法による規制の動きも各国で盛り上がっており、一部ではすでに実現しています。

プライバシー侵害とは、人が物扱いされることである

物は、人からじろじろ見られても、中身を分析されても、持ち運ばれても、分解されても、何の問題もありません。理由はそれが「物」だからです。

物と人は違います。人間は尊厳ある存在です。頭の中身を勝手に閲覧されたり、体の組成を勝手に分析されたり……といったことがあれば、それは物扱いに等しい。これがプライバシーの出発点なのです。

この記事を読んで青くなった方はまず、SNSなどオンラインサービスの使い方やアカウント設定を見直すといいでしょう。これはなにも、自分のことは絶対誰にも何も教えてはいけないということではありません。もし根拠なく疑心暗鬼になるなら、かえって精神衛生に悪いです。

「プライバシーを守る」とは、「自分に関する情報を自分の管理下に置く」という意味です。相手企業にどこまでなら教えていいか。相手企業はあなたに関する情報をどう利用しているのか、第三者の手にわたることはあるのか。そのあたりを意識するようになった時から、プライバシー環境は飛躍的によくなります。

楽しい会話の相手は、AIキャラクターではない

ここまで読んできてうすうす感づいたかもしれませんが、最初に忠告しておくと、次に紹介する問題点は、スマホアプリとの会話を日々楽しんでいる人にとってはショックで青ざめるような内容に違いありません。しかし、自分がしてきたことの危険性に今気付くことができたなら、それは幸運。気づくのが早ければ早いほど、傷は浅くてすむからです。

フレンドリーなスマホアプリのゾッとする裏側

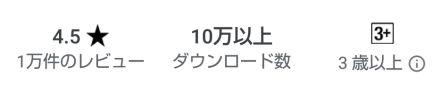

さて、最近、人間と会話するのと同じようにおしゃべりを楽しめるスマホアプリが人気になっていますね。たいていは、基本無料。アプリとしてはエンタメ扱いで、AppleのSiriのようにスマホ本体に最初から入っていたり、ダウンロード数がかなり伸びていたりします。

……スマホ画面の向こうにいる、アプリの運営会社について考えをめぐらせたことはあるでしょうか。

人気になっている多くの会話AIアプリでは、「あなたの気持ちや嗜好、価値観を知りたがるので、答えてあげると仲良くなれる」「悩みを相談すると、それに沿った受け答えをしてくれる」「話したことを記憶して、会話すればするほどあなたに沿った提案をしてくれるようになる」などといったことが「魅力」として紹介されています。たいていスクリーンには親しみのわくマスコットや人物が登場し、「キャラクターと会話する」ことになっていますね。

しかし、その意味を冷静に考えたらどうでしょう。

かわいらしいキャラは、表面的なグラフィックにすぎません。現実には、あなたとAIとの「会話」は全部、アプリの運営会社に送られているのです。

自分の氏名、年齢、性別、家族構成、学校名や職業(会話した内容によっては、細かな内情まで)、スケジュール(カレンダーアプリとの連携から)、趣味嗜好(検索ワードやしゃべった内容などからわかる)はもちろん、体重や健康診断の数値といった普通だったら友人にさえ見られたら恥ずかしいデリケートな個人情報、さらには同僚の誰それの愚痴や体形の悩みといったきわめて個人的な心の内側に至るまで――これだけリッチな情報を差し出してもらえれば、見ず知らずの他人でも、あなたがどんな人かを恐ろしく正確に描き出すことができます。もう一度言いますが、ひとたび話してしまったら最後、機械(正確には、相手企業のコンピューター)は、自力では忘れてくれません。

インターネット上のサービスを使うとき、スクリーンの向こうには必ず企業が存在しています。常に「相手企業と向き合っている」意識を持っていることが大事だと、私はSNSなどについて解説を書くたびにいつも強調してきました。この意識をもっていれば、「(自分について質問してくる)会話アプリ」と聞けば身構え、相手企業について調べたり、利用規約やプライバシーポリシーを熟読したりするはずなんですよ。ちょっとした遊びのつもりでアプリとおしゃべりしているということは、相手企業を意識するどころか、相手企業の名前すら知らない、なんていうユーザーも決してめずらしくはないのではないかと推察します。

画面の向こうの相手企業は、アプリを通して送られてきたあなたの健康状態や個人的な悩みに至る細かな情報を、一体どのように管理し、利用しているのでしょうか? それは企業それぞれとしか言えないのですが、一般論として、個人情報の売買や利用価値・悪用価値は先に述べた通りです。「遊び」のサイトから集まった人々の個人情報をまんまと「世論の誘導」に利用した人といえば、まっさきにトランプ大統領の顔を思い出してもらえればいいでしょう。

おもちゃが危険物品、違法な監視機器になった実例

現に、会話AIからの深刻な個人情報流出は、海外ですでに報告されています。

“Cloud Pet”というふわふわなユニコーンのぬいぐるみは、Bluetoothでスマホに接続し、専用アプリからインターネットにつなぐことで会話が楽しめるという子ども向けのおもちゃでした。ところが、おもちゃメーカーは音声が送られてくるクラウド上のデータベースにパスワードひとつかけていなかった、ということが後から判明。セキュリティのひどい甘さを突かれ、50万人を超える持ち主のメールアドレス、パスワード、プロフィール写真などといった個人情報、そして220万にのぼる音声データ(幼い子どもやその親が「ユニコーン」にしゃべった一言一言の音声すべて。典型としては、ここから家族メンバーの名前や家族構成がわかる)が流出したとみられています。

ほか、まったく同じ仕組みの子ども向け会話AI人形が、ドイツでプライバシー法に違反する「監視機器」とされ、所持した場合には日本円で約250万円以上の罰金が科されることになった、という例もありました。

これらのケースは、おもちゃ会社が個人情報収集用プログラムにふわふわなぬいぐるみをかぶせて売った、というわけではなかったようですね。言い換えれば、故意ではなかった。過失だった。しかし、悪意がなかったからといって、その物が安全になるわけではありません。危険な物は危険です。こうした会話AIに関しては、一見かわいらしくて愛着がわくし、遊んでみるとおもしろいので、人間(とりわけ幼い子)はまさかそんなに危険なものだとは想像だにしない、という問題点が浮かび上がってきます。

付き合いを見直すなら、今

企業はいろいろです。最初から個人情報収集が目的で「エンタメアプリ」を人々につかませている後ろ暗い企業。悪意はないけれど技術や意識が足りず、管理が甘い企業。集積する個人情報の利用方法を公表して透明性を確保している、比較的良心的な企業。もし音声会話ができるスマホアプリやおもちゃを身の回りに置くなら、まずはスクリーン越しに相手企業の存在を意識して、付き合い方を判断するのが大事です。

……と、ここまではずっと、客観的な語り口で説明してきました。それは私がセンセーショナルに書くことを避けているから、そして、読者であるあなたの自律と尊厳を尊重してのことです。

しかし世の中の現状をみれば、このまま読者を「判断は自分で」と突き放してしまえばかえって公平性を欠く。そう判断します。

ちょっとした遊びのつもりで、全然必要ないアプリから、莫大な、取り返しのつかない代償を払ってしまっている何十万の人たちに、私はぜひともこの場で注意を喚起したいのです。その会話AIアプリは、愛きょうある友達の皮をかぶった、個人情報収集用スパイではありませんか? 気軽なおしゃべりからデリケートな悩み相談にいたるまで、すべての会話は相手企業に分析・利用され、見も知らぬ誰かに売られている――付き合いを見直すなら、今です。

機械学習に利用されている、ネット上の顔写真

人工知能を飛躍的に発展させ、近年の第三次ブームを引き起こした要因は二つあります。ひとつはコンピューターの計算処理能力と記憶容量の向上、そしてもうひとつがインターネットの登場です。人々がネット上にテキストや画像、音楽などを無数にアップロードするようになったことで、以前ではあり得なかったおびただしい量のデータ(「ビッグデータ」)が誕生しました。しかもそれは、ネットにつなぎさえすれば誰でもかんたんに手に入れられます。機械学習という独特な方法で開発される人工知能にとって十分な「教材」が現れたのです。

それまで人工知能の発展を阻んできた壁を取り払ったのは、インターネットがもたらした輝かしい副産物だったしれません。ただ、これを一般のインターネット利用者の立場から見たらどうでしょう。いま、世界中の人がSNSに自分の写真を投稿して楽しんでいる。食べ物や動物をスマホカメラで撮ったり、日常でのささいな出来事や思ったことを文に書いたりしてはネット上にアップしている。これらのすべてが、人工知能の研究開発に使われているのです。

もっとも、「ネットに投稿したものは不特定多数の誰もが見られる」というのはインターネット利用の大原則です。見た人が自分のパソコンに保存するなども可能です。自分でネット上に投稿したものを見るな、使うなと言えるかといえば、それにはやや無理があるかもしれません。

しかしそう分かっているとはいえ、自分の投稿がAIに読み込まれて機械学習の糧になっているとか、そのままストックされているかもしれないとなればやはり気味が悪いですよね。とりわけプライバシー上の問題を生じさせるのは、顔認識の開発です。ネット上にアップロードされた顔写真が、本人の知らない所で顔認識AIの研究開発に利用されているからです。

こうしたAIの開発方法が世間に知れ渡るにつれ、顔認識をめぐってはプライバシーへの懸念が聞かれるようになりました。企業や研究機関に対しては、どこからディープラーニング用のデータをとっているのか、集めたデータをどう利用しているのか、保存はしているのかといったデータ利用の透明化を求める声が上がっています。

こうした流れを受け、2022年6月には、Microsoft社が開発者向けクラウドプラットフォーム「Azure」内の顔解析AIツール「Face」で、性別、年齢、笑顔、ヒゲ、髪の毛、化粧などのID属性推測機能を廃止すると発表しました。さらに、Microsoftへ利用目的などの申請を課すことで、同ツールへのアクセスを制限。すでに新規ユーザーへの提供は停止済みで、2023年6月末には既存ユーザーへの提供も終了するとしています。

科学研究の倫理を考えれば、人工知能を開発する企業・研究機関が機械学習への利用データや利用方法を公開することはとても大事です。加えて、私たち一般のネットユーザーも、SNSなどに投稿する際には防犯の視点だけでなく、AIの研究に使われるかもしれないのだという意識を備えておくべきでしょう。誰に、どのように使われるかを知ってはじめて、その顔写真をネット上にアップするかどうかを自己決定できるからです。

人工知能とインターネットとプライバシーの関係

人工知能とインターネットとプライバシー。この三者は、密接にかかわり合っています。

データを取り込むことで「学習」し、機能するAIには、情報が集積します。どんな種類のデータを取り込むかはプログラムによります。開発中の顔認識プログラムだったら、SNSにアップロードされた全世界の顔写真。防犯カメラに搭載されたプログラムなら、防犯カメラが撮影した映像は自動的に送信されます。アメリカの裁判所が先の「人種差別ロボ」に読み込ませたのは、犯罪歴や再犯のデータでした。ネットショップの「おすすめ」プログラムだったら、全ユーザーの閲覧履歴、購入履歴、ユーザーの属性や時間帯など。GoogleアシスタントやSiri、Alexaだったら、あなたのウェブ検索履歴、閲覧履歴、話しかけた内容、アプリの使用状況、位置情報……。などなど。

直ちに危険だとは言いません。安全が確保されていればいいわけですが……。

企業や公的機関がどのソフトウェアをどのように使っているかは、不透明と言わざるを得ません。私たち人間がAIというテクノロジーに見合ったルールをつくることに失敗すれば、恐怖の監視社会につながる可能性は十分あります。

もしあなたがスマホや家庭用のAIを使っているなら、機器や通信に脆弱性はありませんか? 利用規約やプライバシーポリシーには何と書いてありますか? 相手企業は? 信用できますか? 機械は、忘れない。遊びのつもりで手を出せば、ひどく後悔することになりかねません。

兵器―今すぐ国際的法規制が必要

すばらしいテクノロジーのように取りざたされる人工知能を不安に感じ、デメリットはないのかと知りたがる人は多いようです。そんな不安の中で最も気になるのは、やはり兵器・軍事への利用ではないでしょうか。もしかしたらあなたはどこかで、ロボット兵器が人を検知して自動で殺害するのだ……といった恐ろしい話を耳に挟んだかもしれません。

考えたくもない、という気持ちは分からなくもないですが、何事も事実を知らないことにははじまりません。「AI兵器」とは具体的にはどのようなもので、現時点で実在しているのでしょうか? 開発はどこまで進んでいて、何より、実際に使用されているのか。ここでは、人工知能の兵器への搭載や軍事利用のいまを解説しようと思います。

無人型兵器の種類

指で引き金を引く。コックピットに座って操縦する。こうした軍事装備は人の肌に密着していますが、世の中には人の手を離れるタイプの兵器もあります。「無人型兵器」です。

無人型兵器は、次の3種類に大別することができます。すなわち、

- 準自律型

- 人間監視自律型

- 完全自律型

の3種です。

1番目の「準自律型」は、人が出した指令で標的を選んで攻撃するものをいいます。典型的には、コントローラーとモニターで遠隔操縦するロボットを考えればいいでしょう。2番目の「人間監視自律型」は、オペレーターの監視下で兵器が標的を選び、攻撃します。

そして3番目の「完全自律型」は、人間が介在することなく、プログラム(=AI)が自らの判断で標的を攻撃します。

同じ無人型兵器の中でもとりわけ問題となるのが、3番目の「完全自律型」です。人が遠隔操縦や命令をしたり、監視下で使用するならまだ「道具」の範疇ですが、機械が自分で判断して攻撃するとなれば、まったく新しい法的、倫理的問題点が生じてくるのです。人工知能の軍事利用は、火薬、核兵器に次ぐ「第3の軍事革命」とも言われています。

AI兵器の開発と使用の現状

人工知能が搭載された兵器は、一部の国ではすでに使用されています。

……と聞いたらぎょっとするのは無理ありませんが、現時点で完全自律型のロボットが戦場を駆けまわって人を探して撃っているわけではありません。軍事大国・アメリカでは準自立型が主流です。たとえば米軍の「プレデター」は人が攻撃を指示する無人攻撃機で、アフガニスタンでの空爆などに使用されてきました。

なぜAI兵器を開発したいのか?

人工知能の軍事利用は、何の目的で、どのように進んできたのでしょうか? まずはその「流れ」を整理してみましょう。

すべての起点となっているのは、「戦闘で可能な限り兵士を危険にさらさず、犠牲者を減らしたい」という希望です。この発想自体は古代から存在する戦闘・戦争の常識であり、新しいものではありません。現代にはロボットやAI搭載ロボットというものがあるので、それを戦闘で活用できたら、という話になっているのです。

戦闘にロボットを導入していこうと決まれば、次には「ロボットをどこでも使用できるよう改良したい」という要請が出てきます。ロボットが大きければ、倒壊した建物には入っていけません。また大きくて重ければ、遠く離れた戦地まで運搬するのは困難です。さらに、使用場所へ運ぶところまではクリアしたとして、戦地は岩場や沼地だという場合も多くあります。せっかくのロボットも、現場で使えないならないのと同じ。こうした理由でロボットの小型化・軽量化が目指され、足元が不安定な場所でも進めるように開発が進められていくのです。

では、AI兵器の開発や使用は、現在どこまで進んでいるのでしょうか? 2019年にフランスのBonne Pioche Televisionが優れた取材をしているので、ここではそれを参照しながら事実を確認していこうと思います。

操縦がいらない自律型ドローン開発のいま

世間一般では、ドローンといったら、テレビ局やYouTuberがコントローラーで操縦し、野生動物や観光名所を上空から撮影するといったイメージが強いと思います。しかし最近の研究開発では、ドローンが人間の操縦によらず、自ら思考して飛ぶことが可能になっているのです。ここで使われるのが人工知能。ドローン本体に、どう飛んで何をするか判断するプログラムを搭載するのです。

現在、フランスの特殊警察では、人質事件やテロ事件の現場の偵察にカメラ付きドローンが導入されています。今の段階では隊員がスクリーン付きのリモコンで操縦していますが、将来的にはドローンが人間の操縦なしに自律して飛べるようになることが期待されているということです。

この場合、ドローンは警察が事件現場で使っているわけですが、刑事事件だけでなく、軍事目的での研究開発も行われています。

たとえば、米ペンシルベニア大学のチームは、国防総省から資金提供を受け、人間による補助や事前情報なしにリアルタイムで見取り図を作れる自律型ドローンの開発に成功しました。念頭に置かれているのは、「ある建物にテロリストが潜伏しているとわかっている」といった状況です。人が捜査範囲を指定すると、ドローンが自律飛行してターゲットを見つけ出し、犯人の潜伏場所を教えてくる、というのです。その研究開発は、行く手に障害物があればドローンが次の行動を自分で判断できるところまで進んでおり、未完成ですが特定人物を探し出す研究も進行中だといいます。

小型化、そして超小型化

現場からの意見や希望により、ロボット開発では小型化・軽量化が進められてきました。戦闘では、敵に見つからないことが求められるからです。

たとえば米軍は、ポケットサイズまで小型化されたカメラ付きヘリコプター型ドローン「ブラックホーネット」をアフガニスタンでの偵察に導入しています。これは数百メートル離れたところにいる隊員に情報を送信することができますが、タイプとしては人がスクリーン付きのリモコンで操縦するドローン。つまり、人工知能搭載の自律型ではありません。

いま世界中で研究開発されているのが、ポケットサイズよりさらに小型な「昆虫型ロボット」です。一例として、フランスの研究所が開発中の「ハエ型ロボット」は、幅わずかに3cm、重さは22g。羽を動かし、ハエの羽ばたきを再現するところまでは実現しており、現在は飛び立たせる実験をしているということです。

こうした虫並みに小さなドローンの開発で最終目標に掲げられているのは、カギ穴やドアの下から音を立てずに部屋へ侵入し、中に人がいるかどうか、内部の構造はどうなっているかを調べる偵察や、煙や毒物などの探知、集めたデータの送信といった機能を搭載することです。したがって、現時点ではハエ型ロボット本体がまだ飛べない段階ですが、ゆくゆく開発が進めば、カメラや人工知能の搭載が持ち上がってくると予想されます。相手に見つからないことを求められたゆえの小型・超小型ロボットは、戦闘は有利にするかもしれませんが、後で指摘する通り重大なデメリットも生じさせます。

「ロボットたち」の共同作業

以上のような小型化・軽量化のほか、現在盛んに進められているのが、自律型のロボット同士を連携させる研究です。まるで人が役割分担してチームで働くように、人工知能を搭載した「ロボットたち」が共同で作業をするのです。

スイス・チューリヒ大学の実験では、自律型の地上ロボットと上空ロボットを連携して働かせることに成功しています。上空のドローンが地図を作って、視野の狭い地上の自律型ロボットに障害物の位置などを知らせるのです。実験室では「複雑な地形でケガ人にたどり着き、救命キットを届ける」という目的を達成しました。

この実験は災害救助モデルでしたが、ロボットの連携には軍事利用の道もあります。

たとえば、アメリカの国防総省では、航空機から自律型のドローンを「群れ」で発進させ、敵の通信を電磁波で拡散するといった任務をさせるという構想が進行中だといいます。

ロボットには、未知でGPSもない場所や、地形的に人間が立ち入れない場所、煙・毒ガス・放射能などがある危険な場所にも入れるというメリットがあります。もし、戦地に複数のロボットを放って地図を作らせ、茂みに隠された爆弾や隠れている人を見つけ、別のロボットや人間に攻撃を呼びかける、などができるようになれば革新的だということです。

人間を攻撃するのか?

以上を見てくると、無人型兵器の多くは「偵察」を期待されていることがわかります。

では、偵察ではなく攻撃はどうなのか。つまり完全自律型兵器が人を攻撃するのかどうかは、最も気になるところではないでしょうか。

現在のところ、無人型兵器といっても主流なのは準自律型、つまり人間の管理下にあるものです。最初に紹介した米軍の無人攻撃機「プレデター」が人間の指示で攻撃するタイプでしたね。

ただし、なんだ、だったら完全自律型の兵器はまだ存在しないのか……と胸をなでおろしてはいられません。イスラエルは、人が介在せず自ら目標を探して突入、自爆攻撃する無人攻撃機「ハーピー」を開発、そして配備しました。中国やインドが購入したともいわれています。

AI兵器が人道上問題な理由、現実には当面暴走しない理由

以上、ここまでは軍事用人工知能の開発と使用の現状を整理してきましたが、あなたはどんなふうに思ったでしょうか。以下では、その問題の所在を明らかにしていこうと思います。

まず倫理上なんといっても問題となるのは、完全自律型のAI兵器に人命を奪う判断をさせるのかということです。機械がある人を生かすか殺すか、どの人を殺すかを決める権限を持つとしたら公正さがありません。人権保障のかなめの一つである適正手続きの保障において大きな問題があるのです。また、もしそれを認めれば人間が機械と同列の存在に格下げされてしまう、という人間存在への根源的な危惧も主張されています。

さらに、人的損失が減ることで戦争へのハードルが下がりかねない、という指摘もあります。

こうした人命にかかわる倫理だけではありません。相手に見つからないために開発が進んできた小型・超小型ロボットは、プライバシーにおいて重大な危険性をはらんでいます。とりわけ危険なのが、将来昆虫型ロボットに人工知能が組み込まれた場合です。先ほど紹介した時に勘づいたかもしれませんが、カギ穴やドアの下から音を立てずに侵入するカメラ付きロボットがもし野放しにされたなら、すべての人のプライバシーは完全消滅してしまいます。この類が悪意ある物の手に渡れば非常に危険だということは、かなり前から指摘されてきました(『人工知能は人間を超えるか ディープラーニングの先にあるもの』240頁)。

小型・超小型ロボットは、権力の手に渡った場合、民間人の手に渡った場合、どちらにも重大な危険があります。銃の所持は銃刀法により違法、日本刀にも銃刀法、薬品には薬事法の規制があるのと同じように、製作や入手自体に厳しい法規制をかけなければならない新たな物品だといえるでしょう。

人工知能特有の問題点としては、それをずっとコントロール下に置いておけるかという論点もあります。自ら学習するプログラムは、人が予期しなかった行動を編み出すことがすでに多々あるからです。想定外の事態を何としてでも防ぎ、また対処できるよう手を打たなければなりません。

以上のように、AI搭載の自律型兵器には、人道上重大な問題点がいくつも内在しています。

ただ、このようなAI兵器がいますぐにでも暴走するかといえば、そうではありません。

仏警察特別介入部隊のジャン・ミッシェル・フォヴェルグ元司令官、つまり現場で戦闘を指揮してきた人物は、武装化されたロボットの導入はそうかんたんには進まないと話しています。なぜなら、人質事件やテロ事件において、犯人逮捕までのプロセスにはさまざまな規則があるからです。彼が一例として挙げているのは「正当防衛」です。日本の刑法では「急迫不正の侵害に対して、自己又は他人の権利を防衛するため、やむを得ずにした行為は、罰しない(36条1項)」と定められているこの法理により、たとえば相手が撃ってきたときに自分の命を守るため撃ち返した隊員は罪に問われません。ということは、裏を返せば、ロボットはただの機械=モノなのだから、撃った場合正当防衛は成立しません。これでは事件現場では使えませんよね。

さらに、仏国防省国防イノベーション庁のエマニュエル・シヴァ長官は、戦場の兵士がロボットを心から信頼できるようにならない限り、指令は人間が出すと話しています。

こうした言からは、事件現場や戦地で実務に携わる人々にとって、AI兵器は現状そうそう使い勝手の良いものではないことが見えてきます。

「木を見て森を見ず」ではありませんが、現実社会はとても複雑です。世の中では完全自律型兵器について恐怖をあおったり興味本位で語られているところを見かけますが、SF映画のようなイメージ映像は必ずしも現実化するとは限りません。新しいテクノロジーにも、広く複雑な社会での位置づけというものがあるからです。

兵器に人工知能が組み込まれた場合に生じる危険性は言うまでもないので、あらかじめ可能性を予測して、確実に手を打っておかなければなりません。他方、もしかしたらああなるかもしれない、こんなことって起こるのかな、といった根拠のない空想なら、それは理性と事実確認によって手堅く排除していくべきです。

人工知能の兵器・軍事への利用は、個別のロボットや兵器それぞれについて「事実」をねばり強く確認し、ならびに、以前から存在してきた戦争における国際人道法など、現実社会との関係をきちんと把握して論じていくことが大事でしょう。

政府と民間企業・大学とカネ―危険な人間たち

私がここでもう一点指摘しておきたいのは、テクノロジーの面ではなく、研究開発での利権をめぐる問題です。

兵器の開発には、巨大な利権がからみます。

9・11同時多発テロ以来、アメリカは莫大な資金を投じてロボットや監視システムの開発を進めてきました。2020会計年度には、無人型兵器の開発に約37億ドル(約4000億円)、人工知能関連に約9億ドル(約960億円)の予算を計上しています。中国やロシアも、AI兵器の開発に毎年巨額の予算を投入しています。

上記で開発状況を整理したなかでは、研究・開発しているさまざまな大学や民間の企業が登場しましたね。では、その実態は具体的にどういうことなのか。――各国政府は、民間企業や大学に巨額な資金を提供したり、共同開発したりしているのです。

こうした官と民の蜜月はかねてより、汚職や、国家権力による学問の自由抑圧の温床となってきました。

国家権力は民に対し、政府が望む研究をすれば資金を出すし「のってこない」なら出さないと、カネをちらつかせる。企業や大学の側は「カネを得るためには政府の意向にのるといい、のっていかなければ」と官に迎合・追従していき、やがてはその独立性を失う。科学者の倫理、そして政治への批判を含む学問の自由(憲法23条)は隅に追いやられ、民がカネによって兵器開発へ懐柔、誘導されてゆきかねないのです。

汚職や自由の抑圧は、人工知能のせいで起こるのではありません。危ない人間たちが巻き起こす、カネがらみの泥沼です。私たちの暮らす国・社会が取り返しのつかないことにならないよう、官民の癒着、国家権力による大学への支配や学問内容への介入は、研究者自身も、一般市民も、細心の注意を払って監視していかなければなりません。

国際法規制の動き

これまでも新たなテクノロジーが出現するたび、悪用を未然に防ぐための法整備は行われてきました。インターネットはおびただしい規則にのっとって利用されているし、古典的なところでは銃の所持は銃刀法で違法とされています。同じく、AI搭載ロボットにそれ相応の法規制がなされるのは当然であり、その黎明より戦争と密接な人工知能には国際的な法規制が必要です。

科学界、そして多くの国々が、完全自律型殺傷兵器の禁止を求めています。

2017年には、人工知能やロボット工学の科学者ら100人超が国連に「自律型致死兵器システム(頭文字をとってLAWS。キラーロボットとも呼ばれる)」の禁止を求める書簡を公開しました。

LAWSを禁じる国際条約創設の主張もなされています。ただ米・英・ロシア・イスラエルなどは条約づくりに反対しており、もともと人工知能は定義があいまいなこともあって、現状ではLAWSの定義すらはっきりとは定まっていません。

2019年には、スイスで開かれた政府専門家会合で、AI搭載自立型兵器を念頭に「すべての兵器システムに国際人道法が適用される」「兵器の使用責任は人間にある」など11項目の指針が採択されました。法的拘束力はないものの、指針の内容は合理的といえるでしょう。

人類は、もっともらしい理由をつけては戦争を繰り返し、止まらない止まれない軍拡競争を繰り広げては、自らにこの世の地獄を招いてきました。

軍備を減らそうと言っている時に、新手の兵器を増やす方向へ世界が進んでいる――。総体としての人類は、頭がいま一歩な種だと言わざるを得ないでしょう。

そんな人類が考えるべきなのは、頭が良くないなりにはなんとかやっていく方法です。たった一つの世界で共に生きていけるよう社会を整備しなければなりませんし、その程度の知恵ならしぼれるはずです。

人工知能の可能性と未来―全然心配いらないこと

ここまで、AIについて今すぐ対応が必要な問題点を5つみてきました。どれも私たちの生活や権利に被害が及ぶ事例ばかりです。

しかし私が言いたいのは、裏を返せばこれら5つ、すなわち

- 差別

- 冤罪

- 世論の誘導

- プライバシー

- 兵器

以外のことは全然心配いらないということです。人工知能に関する情報は玉石混交……というより、率直なところを言えば、白昼夢レベルの話が平気で闊歩している状況に私はうんざりしています。世には「人類は滅ぶ」などというSF映画のような話まで出回っていますが、冒頭で挙げた例のように、人工知能はそんなたいそうなことができる代物ではないというのが現実です。

すべてテクノロジーは、使い方によって良いものにも悪いものにもなります。それはAIでも変わりません。人工知能がある未来は、可能性に満ちているといえるでしょう。

仕事への活用でより楽に、より幸せに

AIによって変わるといえば、真っ先に仕事の場面でしょう。

「人工知能」と呼ばれ得る物の中で、私たちが日々行っている仕事や特定の業界で使い得るのは、だいたい

- データの分析

- 分析結果をもとにした未来予測

- 作業の自動化

- 異常検知

- 自律型ロボット

の5カテゴリに集約されます。後でじっくり述べる通り、もしこれらをうまく利用できれば、様々な職業でより人間らしい働き方が可能になります。生活にも余裕ができるでしょう。また、新たな発見や発明、画期的な成果が生まれる可能性も秘められています。

他方、この新しいテクノロジーの登場によって消える職業があるといった情報はビジネス界を飛び交っており、「自分の仕事がなくなってしまうのではないか」といった不安の声も聞かれます。仕事でのメリットと、変化への不安感。その両方を見ていくことにしましょう。

仕事がなくなる心配がいらない理由

人工知能の登場で仕事は変わる変わると言われますし、それは事実です。変化の波は、将来といわずすでに打ち寄せています。

ただ、職業事情というのはもとより時代とともに変化するのだということを忘れてはなりません。現在の仕事のやり方や職業の種類は、絶対でも不動でもないのです。

巷にはAIの出現で仕事がなくなる(もっとセンセーショナルな言い方だと「人間が仕事を奪われる」)という流説がありますが、冷静に考えてみれば、これは心配いりません。

過去の一時代を例にとってみましょう。江戸時代の職業事情は、今ではすっかり様変わりしましたよね。たとえば「飛脚」という職業は、自動車というテクノロジーの出現で消えました。自動車の後には電子メールも登場しました。しかし、運送業なら今日でもれっきとして続いています。たくさんの人が、今のやり方で運送業に従事しているのです。考えてみれば、誰もが自動車を運転できる時代になったからといって私たちは荷物を自分で運ぶようになったわけではないし、メールがあるからといって郵便がいらなくなったわけでもありませんよね。

もっと身近な例として、私たちが実際に経験したインターネットの黎明期を思い出してみましょう。インターネットは第三次産業革命だといわれ、様々な分野に華々しい可能性をもたらしました。特に表現活動へのインパクトは大きく、今では個人がブログを開いて文章を発信したり、ビデオを世界に公開できるようになりました。ただそれでも、出版業界やテレビ局がなくなったかといえばそうではない。今では、出版社や新聞社が自社サイトに記事を掲載したり、テレビ局がニュース動画をネットで公開したりするのは世に定着しています。ネットを活用したやり方が増えたのです。既存の分野にもたらされた変化だけではありません。社会にはインターネット関連の仕事・職種が大量に増えました。たとえば「ウェブデザイナー」という職業は今ではメジャーですが、90年代にはまだ存在すらしていませんでした。当時も「インターネットによってなくなる仕事」系統の話はいくらもありましたが、ふたをあけてみれば「インターネットのせいで仕事を失った」なんていう人はいなかった。それが現実です。

「新しいテクノロジーが出てくる→ある職業が消える」というほど、世の因果は単純ではないのです。

さて、人工知能は、あまたの技術がかつてそうであったのと同じく、新しいテクノロジーです。第四次産業革命になるともいわれます。人工知能により仕事のやり方が変わるとか、新しい職業が生まれるといったことは起こるでしょう。しかしだからといって、私たちの仕事がなくなるというわけではありません。人類が今まで幾度となく(時には意識すらせず)経験し、乗り越えてきたことがまた起こるというだけです。

注意すべきものがあるとしたら、それは金儲けをする人間

以上のように、仕事への人工知能導入の実際を言い表すなら、「変化はあるけれど、騒がれているほどたいそうなことではない」といったところでしょう。

にもかかわらず、世の中には人工知能への恐れをあおるような言葉がむやみやたらと出回っています。それはなぜなのでしょうか? またそういった恐怖とは反対に、AIと呼び得るものなら何でもすごいもののように言い立てる風潮も気になります。

もしあなたが「人工知能が出てきたら、自分の人生が暗転してしまうのではないか」などと将来への不安を感じていたなら、それは以下のような文句を目にしたからではありませんか?

- 「人工知能にとってかわられる職業ベスト10」

- 「人工知能が仕事を劇的に変える――不要な人材にならないためのスキルを身につけよう」

- 「AI時代を生き抜くノウハウを教えるコンサルタントです」

- 「ライバル社はもう人工知能を導入している!? 乗り遅れた企業は淘汰される」

- 「AIに負けない子を育てるメソッドを紹介します」

こういった本や記事などは「人工知能についての(正しい)情報」のように見えて、そうではありません。では何なのかといえば、宣伝(マーケティング)です。まともな本や記事、テレビ番組といった姿かたちは化けの皮。巧みに隠されているかもしれませんが、それはあからさまなCMの形をとらない宣伝なのです。

「まずは脅して不安感をあおる→商品/講座/本/サービスなどをドンと持ち出す→『これを買えば安心ですよ』とせまる」という「不安解消型」の宣伝は、詐欺や悪質商法の典型的なパターンです。

例をいくつか挙げてみましょう。大学の新入生に「これからの時代は英語ができないと就職できないんですよ」とすり寄って、高額な英会話教材を買わせる悪質業者。最近この手でよく聞くのは、投資関連の教材です。将来にお金の不安がある時代だからでしょう。この類は性質悪いですが、法律的には詐欺ではなく、正当な売買だというケースもよくあります。あと以前よくあったのが、シロアリ駆除業者。テレビでやっていたシロアリ被害の話題に便乗して(あるいは自ら裏で動いてシロアリのおそろしさを世に垂れ流して)家々を訪問し、「今話題のシロアリ被害、無料検査実施中」だと言って軒下や屋根裏にもぐりこみ、「お宅の柱もシロアリにボロボロにされてます! このままでは家が倒壊しますよ!」と写真を見せて住人を青ざめさせ、駆除の申込みをさせる。

……悪質商法のこういうパターン、なるほど、と思いませんか?

上にリストした文句は、このパターンの新バージョンにすぎません。まずはAIへの恐怖と不安感をあおることで、書籍やスキルアップ講座、子供向けの教材などを直接または間接的に買わせるわけです。

まったく、あくどい商人の考えることはいつの時代もあまりに変わらないので、むしろ感慨すら覚えるほどです。

もっとも、うさんくさい商人だったらとうの昔からいました。AIスピーカーをすごいすごいと言い立てる宣伝広告は、江戸時代に大げさな実演販売をしたガマの油売りや、大正時代に派手な口上で客をよせたバナナのたたき売りの現代版。ちょっとしたうさんくささやオーバーな表現だったら、商売の世界ではご愛嬌かもしれません。

しかし、情報過多で大衆化が進み、フェイクニュースが世を荒らしまわる現代では、根拠なき不安をあおるのは「ご愛嬌ですよ」ですむでしょうか。

人工知能自体は怖くありません。しかし、いいかげんなことを吹聴して人々の不安感をあおり、世を混乱させてでも自分が金を儲けようとする人間には戦慄します。

見下げ果てた「商人」は批判に値するでしょう。しかし、私たちがだまされなければ、実害は生じません。AIに関する話題を耳にしたときは、話が水面下で金儲けにつながっていないかどうか、立ち止まって考えるくせをつけるといいでしょう。

以上のような「商人」に出くわしたら、文字通りに受け取って「大変だ……」と真剣に悩むのではなく、ガマの油売りや、バナナのたたき売りや、投資の教材や、シロアリ駆除業者なんかを頭に思い浮かべつつ、「てえへんだっ!」くらいの軽いノリで受け流すことをすすめます。

AI活用でうんと楽になる業界や職種は?

「てえへんだっ!」くらいのノリで「商人」を追っ払ったら、いよいよ人工知能の可能性について語りたいと思います。

AIによる自動化・機械化をうまく活用すれば、私たちはより人間らしい生活へと踏み出せます。私はその可能性にとても期待しています。

農業・漁業・畜産の効率化と負担軽減

人工知能に期待の目を向けている分野として、まずは農業、漁業、畜産が挙げられます。プログラムやロボットの研究開発は盛んに行われており、その一環としての活用はすでに始まっています。

農業においては、ビニールハウスの温度管理を人工知能が自動で行う、過去の天候データなどの解析に基づいて収穫時期を予測する、といったことが可能になります。

また、先ほど軍事利用の問題で紹介した自律飛行型ドローンですが、使う場面が農業になればそのメリットが活きてきます。これまで人が時間と労力をかけて行ってきた農薬散布や広大な農地の見回りを、自律飛行型ドローンが代行できると期待されているのです。

AIによる温度管理や見回り、異常検知などは、農業だけでなく畜産業にとっても画期的です。これまで人間が24時間つきっきりで行わなければならなかった家畜の世話・管理が、人工知能の活用によって飛躍的に楽になると見込まれているのです。

漁業への応用では、過去のデータや天候などに基づく漁獲量や漁場の予測が考えられます。

以上のように、自然や生き物を扱う産業に人工知能という新しいテクノロジーを応用すれば、人間が長時間拘束される仕事や、あいまいな勘を頼りにやってきた仕事の負担がドラスティックに減少すると期待が高まっています。時間短縮や負担減によって農業や漁業、畜産業の魅力が高まれば、新たにチャレンジしたいと手を挙げる人が出てくる、いうこともあるかもしれません。

製造業で時間短縮、危険な作業からも解放される!

農業・漁業・畜産と同じように人の負担を大幅軽減できると期待されているのが、製造業です。こちらもAIの研究開発が進み、一部の企業では実用化がすでに視野に入っています。

より具体的には、従来の製造機械に画像認識を組み込んだカメラやセンサーを搭載することで、製造過程の時間短縮が見込めるようになりました。工場では一日に何百、何千という単位の物が製造されるので、個々にかかる時間が数秒でも短くなれば生産性は大幅に上がります。

また食品製造では、味を決める微妙なノウハウをAIに学習させ、工場で併用することで、人間が張り付いて行っていた工程を効率化する、といったビジョンがあります。一部の企業は開発に巨額を投資してきて、試験運用を始めるなど実現はもう視野に入っています。「熟練の技」などといわれていたノウハウが分析されることで、よい味が生まれるメカニズムが解明されたり、新しい発見から新たな商品のアイデアが生まれるといったことがあるかもしれません。

さらに、製造業でのAI導入には安全性向上の期待も高まっています。自動車工場などの一部工程には、肉体的な負担が大きかったり、危険を伴う作業があります。もちろん操業にあたっては安全への配慮は行われているのですが、それでも転落や工場機械への巻き込まれなど、従業員が四肢切断するような重大事故、また死亡事故は、工場ではこれまで絶えず起こってきました。こうした危険な工程をAI搭載ロボットが代行できるようになれば、人間の従業員は健康や命の危険から解放されるのです。たとえロボットによる作業代行まではいかなくても、安全確保のため――たとえば、工場の狭い通路や機械の付近、高い所などにカメラやセンサーを設置して、人がいる、物があることを検知したら警告を発してもらうなど――といった活用法も考えられます。

過去のデータ分析や未来予測が役立つ業界は?

人工知能でできることといえば、過去のデータの分析や、それに基づく未来予測が代表格の一つです。したがって、日ごろから人々の動きをつかみたがっている業界、今後の予想がのどから手が出るほど欲しい業界は恩恵を受けることができるでしょう。

先行き予想が命の金融業では、「フィンテック」といって、過去のデータ分析から株価などの予測データをはじき出す技術が注目されています。投資家にとって良い参考資料になっていくでしょう。また金融と関連して、不動産の価値の査定、保険金の支払い可否の判断などでは、プログラムによる自動化の動きがみられます。

過去のデータ分析は、人の動きを予測することにも活用されます。たとえば、大型イベント時に道路や交通機関の混雑を予想できるようになるでしょう。スーパーなど小売業では、過去の天候や売り上げデータを分析して売れ筋商品を予測し、事前に仕入れることができれば売上アップにつながります。

文字起こしに自動翻訳……人工知能がオフィスの備品に

製造、小売りなど業界単位だけではありません。自動化ソフトや画像認識は、業界問わずオフィスでの事務仕事を便利かつ効率的にすることができます。

冒頭でちらりと触れましたが、紙の書類のデジタルデータ化や文字起こしアプリなどは、すでに事務系の仕事に入ってきています。あぁ、使ってるよ、という読者もいるかもしれません。今後は、スケジュールの作成や管理など、秘書的な役割を自動化するソフトが出てくるといわれています。今私たちが仕事でパソコンを利用しているのと同じように、オフィスで働く人が将来そうしたソフトを使って働くようになることはほぼ確実です。

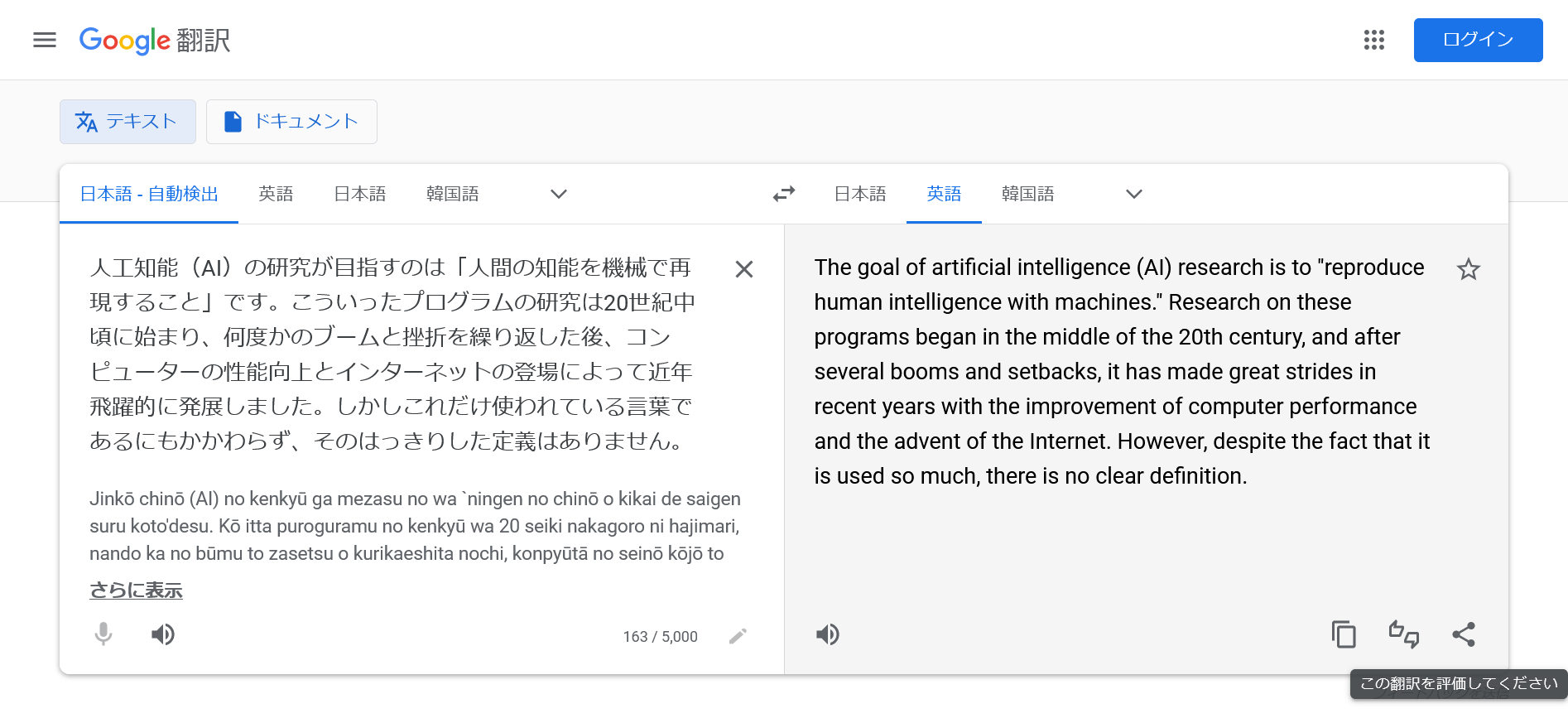

とりわけ目覚ましい発展をとげているのが自動翻訳です。

ためしにGoogle翻訳を思い出してみてください。2015年くらいでしょうか、そのころまではGoogle翻訳のクオリティといえば「笑える訳」としてネタになるなど遊びの範疇で、とてもではありませんが実用に耐えられる代物ではありませんでした。それがたった数年で驚異的な発展を遂げ、今ではまるで人間が訳したかのような自然な翻訳ができるようになっています。

このように、自動翻訳は、日本語から英語という異質な言語間、また専門用語が含まれる複雑な内容でも、きちんと意味が通り、文法にも混乱がなく、しかもネイティブのような流麗な表現ができるまでに発展したのです。このクオリティならビジネスシーンでも利用できますね。

文の翻訳だけでなく、自動通訳の開発も進みました。手に持ってしゃべると訳した音声を出してくれる、ポケットサイズの通訳機が話題になったのは記憶にあるかと思います。

外国人と交流して仲良くなりたいなら直接フレンドリーに会話することが必要ですが、ビジネス書類の作成や取引上の会話であれば機械翻訳でも十分です。他言語コミュニケーションの敷居が今より低くなるため、国際取引が盛んになっていく可能性があります。

かつて世界に電卓やコピー機が現れ、オフィスの備品として定着したのと同じように、AIもまたオフィスの風景にとけこんでいくでしょう。

画期的な学問研究

最後に、一般的なビジネスではなく、学問研究に開ける新たな可能性を紹介しましょう。

下記で詳しく述べますが、人工知能は音声の解析や合成を可能にしています。これにより、たとえば歴史学で、ヒトラーの膨大なスピーチを分析にかけ、多く発せられた単語を年ごとに割り出すことでプロパガンダ戦略の変遷を明らかにするなど、画期的な学問研究が行われるようになりました。

膨大なデータを解析できるコンピュータープログラムが登場したことで、人間では時間と手間がかかりすぎるので考えられなかったような研究が可能になったのです。

ただ、これはプログラムがありさえすればすばらしい成果を自動でポンポン生成してくれるという意味ではありません。活用する技術の選択(画像認識を使うか、音声解析は役に立つのか、など)や、使いどころの見極めは、あくまで人が行うこと。自分は何を明らかにしたいのか、また、人工知能を使ってデータをさばくことがその研究に役立つのか、といった視点は、人間の知恵の絞りどころなのです。

イラストレーターのかつてない便利ツール

イラストや写真といった分野の人工知能は急速に発展しており、2022年には画像生成AIが一般向けに次々とリリースされました。詳細は下記アートとの関係の項で解説しますが、こうしたソフトへ作りたい画像に関するワードを打ち込めば、見ておかしくないクオリティのイラストや写真をたった数分で生成できます。

こうした話題が盛り上がるとさっそく「イラストレーターは不要になる」という説が持ち上がりました。が、それは極論であって、現実的ではありません。

なぜなら、画像生成AIは人間が指示した通りの画像を作れるわけではないからです。一例ですが、ネットメディア・ITmedia NEWSの記者が試しに「牛乳を注ぐ女」を描かせるという企画を実施したところでは、腕が不自然に曲がっている、顔に目と口がない、などといったことが頻繁に起こっています。このクオリティでは、出版社等が人間のイラストレーターを人工知能に置き換えることはできません。イラストレーターにとって画像の自動生成はデジタル化などに続くターニングポイントではありますが、その職業が不要になるというのは机上の空論でしかないのです。

むしろ、画像自動生成ソフトが出てきたことで、イラストレーターの仕事には様々な恩恵があるといいます。

具体的には、まずアイデア出しです。生成された画像から新しいアイデアを得られるようになったのです。

また、作品のバリエーションを作るのは以前ではあり得ないほど簡単になりました。たとえば、打ち合わせでクライアントに多くのカラーバリエーションを見せる、といったことが可能になっているのです。

さらに、制作過程においても、輪郭を自動で認識して切り取るなどの機能は、作業時間の大幅な短縮につながります。画像生成AIは、イラストレーターがアイデアを練る段階の新たな「資料」となり、また色付けなど制作の一部を自動化することで作業時間を短縮できると予想されているのです。

ただし、こうした生成AIとクリエイターの関係では、著作権など全く新しい課題も浮かび上がってきています。これについては長くなるため、単独の新しいページでまとめましたので、以下リンクをご覧ください。

関連記事:生成AIとは?―どこが問題点で、何が起こっているのか

人工知能が作る芸術作品―人間のアートが永遠である理由

学習システムの進歩(ディープラーニング)により、人工知能が絵や音楽、小説や映画などアート作品を作れるようになってきています。

アートにたずさわる人のなかにはそんなAIを脅威と感じ、拒絶反応まで起こす人もいるようです。しかし、現実にはこちらもまったく心配いりません。(もっとも現段階では、「ベンジャミン」というプログラムが生成した映画の脚本はおそまつな出来だったというのが現実なのですが。)

表現は人間の根源的な欲求―自己の存在証明としてのアート

そもそも、人はなぜアートを作るのでしょうか?

自分が表現したいから。人類が表現をする目的は、つきつめればそれに尽きます。10年かけて緻密に組み立てた叙事詩であれ、自分に宛てて書いたつらい体験の手記であれ、ちょっとフォロワーに見せたいなと思ったパフェの写真であれ、すべての表現は「やろうという気持ち」が出発点です。作品という成果物は、必ずしも最終目標ではありません。

表現することは、人間であることと切っても切り離せない、根源的な欲求なのです。

いつの日か人工知能が人間のアーティストとまったく同じ作品を生成した、と仮定しても、それは創作をやめる理由にはなりません。アートは、表現したいという気持ちと、表現する行為・行動に意味がある営みだからです。

芸術作品を機械的に作る「人間」が、昔から大勢いる

と、このように芸術表現の根本を確認したところで、今度はアートを受け取る側の視点に立ってみようと思います。

テレビ番組のAI特集で、アナウンサーが「機械が作ったものなんかに感動させられたくない~」と言っているのを目撃しました。

しかし、私はなんだか気の毒になってしまいました。

というのも、実は、小説や漫画、映画の脚本、歌などを「機械的に」作っている人間の作家・アーティストはすでに大勢いるからです。

アートの分野それぞれには、作品のパターンが人間によって抽出されています。たとえば映画だったら、登場人物を「パターン」から選んで組み合わせ、ストーリーの「テンプレート」にはめていくだけで、うけるストーリーは簡単に作れます。エンタメ業界には「ヒット作を作るのは簡単だ」という格言があるそうです。機械的に「うけるストーリー」を生成したら、あとは人気の俳優や歌手を起用して、宣伝費をかければ、客は一定数集まるのでヒット作になるのです。

こういった「作家・アーティスト」がする「創作」は、機械的な作業にすぎません。このタイプの「作家」は、他でもない本人たちが「芸術家ではなく職人だ」とよく言います。

あなたがうんと感動した小説や漫画、映画、歌なども、実は想像しているほど芸術的なものではなく、作者がテンプレートにあてはめて生成し、売りに出した「コンテンツ」にすぎない可能性は十分あります。言い換えると、機械的に作られたものに感動させられたことは、人工知能がない時代から、誰にでもすでにかなりの回数あるでしょう。人工知能が芸術作品を作るのは、農薬散布などと同じく、人間の職人型作家・アーティストがやっていた「作業」をAIが部分的あるいはすべて代行するようになる、というだけの話です。

作品を機械的に作る「アーティスト・作家」の存在をこの記事で初めて知った方は、おそらくひどく幻滅して、アートに不信感を募らせたことと思います。夢を壊してしまってなんだか申し訳ないので、あまり深くは立ち入れませんが、だったらどうすればいいのかについても言及しておきます。

すべてアートに触れるとき、いちばん大事なものは、主体性です。

その作品が機械的に作られたものか否かは、一応意識しておいたほうがいいでしょう。作者はどんな人物で、何のためにそれを作ったのか。それを確認すれば、確証まではないとはいえだいたい判断できます。(ちなみに、作者の権威や知名度はまったく参考になりません。ヒット作を作るのが簡単なのと同じように、「権威ある作家」もビジネスのテンプレートに沿って「作る」ことができるからです。)そうやって「大人」な広い視野をもっていれば、時の権威・権力のプロパガンダに踊らされる危険をうんと減らすこともできます。

仮にそれが機械的に作られた「コンテンツ」だったにせよ、だから直ちにだめということではありません。好きだったら胸を張って好きでいい。アーティストの在り方は自由かつ多様で、こう在らねばならないというただ一つの答えがあるわけではありません。人を楽しませたい一心で作品を作ったエンターテイナー型の作者に対して、「楽しませてくれてありがとう!」というやさしい気持ちは貴重です。

どう感じたか。どこに感動したのか。そういう気持ちや考え方は、他の誰とも違う、あなたの完全オリジナルです。アートに触れるとは、他者と出会うことです。好みや感じ方から自分が見えてくる、ということでもあります。

では、その作品(ないしコンテンツ)に価値はあるのか。その問いに、自分以外の誰かが用意した解答はありません。評論家やヒットチャートなど、いかなる権威やデータにも賛同する理由はありません。それは自分の頭で考え、自分で決めることだからです。

自分は自分。自己表現に他人は関係ない

すべての人は一生のうちで、表現の受け手・作り手の両方をとっかえひっかえ、星の数ほど経験するもの。次には、アートを作る側の視点に立ってみます。

私には、一部のアーティストがAIに脅威を感じる理由が理解できません。だって、自分の創作に他人のことは関係ないじゃないですか。

他にもアーティストがいるから、という理由でアートをやめてしまう人などいませんよね。私たちは、他に何万人いようが自分も作家になったり、伝説の奏者がいようが「好きだから」という理由で楽器を演奏したり、他の人がすでに投稿していようが自分もパフェの写真を加工してアップロードしたり、といったことをごく普通にしてきました。その「他人」がコンピューターであれ、何ら変わりはありません。他人は他人、自分は自分です。

もし「職人型の作家」が仕事がなくなる心配をしているなら、この記事をさかのぼってもらえばいいでしょう。職業事情は、常に移り変わっています。今とまったく同じ形ではなくなるかもしれないけれど、その時代には似たような仕事があるはずだから、問題ありません。

個人的な思いを語らせてもらうなら、「AIの進出」を心配している作家にとって、自分の作品はそんなことでやめてしまう程度のものなんでしょうか。自分の意志で作品を作ったことがある人ならわかると思うんですけど、できあがったのがどんなものであれ、作者には誇りがあるはずです。心もないのに肩書き欲しさで作家になったからそんな心配に迷い込むんじゃないか? 自分が機械みたいな人間だから「別の機械」の出現が脅威なのでは? 最初に書きましたが、アートは心です。

私は作家です。言いたいことを言う。自分が表現したいと思ったものを作る。それはいつまでも変わりません。人間並みの作品を作れるプログラムが出てくるのが、私はむしろ楽しみです。

「AIが再現した故人」は本人ではない―美空ひばりの歌声再現から

近年、「AIがすでに他界した有名なアーティストを再現する」という趣旨のテレビ番組が見受けられます。2019年にはNHKが「歌手の美空ひばりをよみがえらせる」という年末番組を組みました。こうした「人工知能で故人を再現」の類について、ここで事実をまとめておこうと思います。ここまでずっと読んできた人にとっては全部当たり前だと承知しているのですが、念のため、です。

まず、コンピュータープログラムに美術、音楽、小説等の歴史上の人物をまねさせる試みは、かねてよりありました。レンブラント風の絵画を生成させる、ショパン風の曲を生成させる、といったことは一部ですでに可能となっています。今日では偉大な画家や作曲家にも、その道への第一歩を踏み出した日はありました。彼らは美術学校の門をたたくなどして勉強し、技能を磨き、自分なりの考え方を確立していったのです。ソフトウェアがその技術や思考法をなぞっているだけなのだから、とくに不思議な点はありません。

「美空ひばりをよみがえらせる」番組について言うなら、まず、音声合成ソフト(ヤマハのボーカロイドなど)の研究・発展は、かれこれ十余年前より盛んになっています。ボーカロイドと聞くとアニメ風のキャラクター・初音ミクなどを思い浮かべる読者もいるでしょうが、音楽ソフトという観点で見れば、あれは一つの娯楽向け企画商品にすぎません。

参考リンク:ゼロからわかる!初音ミク・ボカロPとは&音楽制作の行方

音楽制作には、録音、音響効果、録音した音源の編集、自動作曲、楽譜の作成、そして楽曲の制作などさまざまなソフトがあり、楽器店やパソコンソフトの売り場に行けば誰でも買うことができます。うち、パソコン上で楽曲の各パートを「打ち込む」ソフトは、プロはもちろん多くの音楽愛好家に使用されています。たとえば歌とギターをやるミュージシャンだと、あらかじめ音楽制作ソフトでピアノとドラムとバイオリンのパートを作っておき、その音源を流しながら自分がいっしょに歌うことで、バンドを組まずとも一人で5パート分の壮大な音楽を演奏できる、といった具合です。こう考えれば、音声合成ソフトというのは「ボーカルのパートを作れるソフト」という位置づけになりますね。

人工的な声を作るだけではありません。最近では音声データを解析するプログラムも発展していて、上記で述べたような画期的な研究を可能にしました。先の番組で美空ひばりの歌唱技術やくせを解析するのには、こうした音声解析プログラムが使用されています。なので、美空ひばりの歌声を再現したのは「人工知能を併用した音声合成プログラム」だということになります。

以上のようなソフトウェアによる「亡き人の再現」は、コンピュータープログラム事情を正しく理解している人には少しも驚くようなことではないでしょう。また、音声解析により美空ひばりの歌唱法を研究するのは、とりたてて後ろ暗いようなことではありません。優れたボーカリストの歌い方を研究するのは、歌手を目指す人が練習の一環として、あるいは音楽愛好家が耳を使って、昔から普通に行われてきました。

「故人の再現」に関してもし注意点があるとすれば、それはあくまでソフトが合成・生成したものであって、本人とは一切関係ない、ということでしょうか。

「よみがえらせる」などという言葉の表現からは、「死者を復活させる禁断の技術……」とか「死んだ人が生き返ってあなたの前に現れる」といったホラーファンタジーのような印象、あるいは「亡き人のコピーを人工的に作ったのだ」といったSF映画のようなイメージが連想されるかもしれません。しかし、できあがったものは、あくまでデータ解析に基づいた新しい作り物。当たり前すぎて説明するのがはばかられるくらいなのですが、映像や音声、しゃべり方などがたとえどんなに似ていても、それは本人とはまったく別の物体です。本人の手は一切加わっていません。同意もありません。視野を広げて見ればわかりやすいでしょう。人間がこれまでもやってきた分析作業に最近のソフトウェアを導入した、ということです。

テレビの娯楽番組は、物事を「おもしろく」語らなければなりません。視聴者の興味を引き付け、楽しみを提供するために「死んだ人をAIでよみがえらせる」などとセンセーショナルな表現をするのです。こうした番組と付き合うときには、「ファンタジー風の慣用表現を言葉通りに受け取らないように」という点だけは必ず頭に置いておくべきです。冷静な頭で現実を見据えればとてもかんたんなので、心配はいらないと思うんですけどね。

「新たな画材」としての画像生成AI

上記の通り、人工知能に絵を描かせる試みはかねてより行われており、近年では市販の画像編集ソフトにも、絵の輪郭を自動で認識するなど一部の機能が搭載されるようになってきました。

こうした動きの中、2022年には画像生成AIが続々とリリースされました。IT業界やSNSをにぎわせたのは次の4つのソフトです。

- Midjournery

- Stable Diffusion

- ERNIE-ViLG

- NovelAI Diffusion

出来上がる絵がかなり本格的だというので、世界中で話題をさらいました。

技術革新が、クリエイティビティに貢献する

イラストレーターでなくても、誰もが望んだ絵を瞬時に描ける時代になる――画像生成AIの話題が盛り上がった時、そんな夢のようなソフトを想像した人は少なくありませんでした。

しかし、現実はそうではありません。

これまでの人工知能と比べたら飛躍的な発展かもしれませんが、絵のクオリティは私たちが実用するには不十分です。人間キャラクターを描かせたら手首から先がなかった、剣を持った女の子を出力したら刃の部分を握っていた、などという例はいくらでもあります。ただの遊びなら「おもしろかった」で済むでしょうが、そのまま使える絵ではありません。もし修正したいなら、結局、絵や画像編集の技能が必要になるのです。

こういったあからさまな不自然さは、今後の研究開発で穴埋めされていくと予想されています。しかし、それでも未来永劫越えようのない壁はあります。画像生成AIを使うには、あなたが頭の中で想像したイメージを、言葉に直して伝えなければなりません。たとえば「大人っぽい女性がビジネスバッグを肩にかけてビルの前を歩いている」「夜の森に赤い巨大な怪物が立っている」と打ち込んだとして、このワードをプログラムがどう処理するかはプログラム次第です。意図したのと違った絵ができてくるのは、研究開発が進んだところでなくなりようがありません。「顔の表情が気だるいのが気に入らない」「こんなモサモサした怪物は求めてなかった」といったように、イメージとの食い違いはいくらでも生じます。テレパシーではあるまいし、頭の中で描いた通りの絵がソフトから出てくることはあり得ないのです。

シンプルかつディテールにこだわらないカットイラスト程度の場面なら、自動生成は従来のカット集やストックフォト(写真販売)と並んで普及していくかもしれません。私もサイト運営者として、図解やサムネイルなどの作成に、そう遠くない将来画像生成サービスを利用できるようになるのではと予想しています。

しかし、人の考えを「絵」という形に具現化して表現する芸術的な作品は、それらとは根本的に違います。思い通りの絵を描きたければ、人間が地道に絵を練習して技術を身に付けなければならないのです。

画像生成AIの未来は、「絵の素人でも頭で想像した通りの絵を描かせられる」という夢のような話ではなく、「クリエイターが制作の新たな道具として活用する」という線が現実的でしょう。言ってしまえば、画像生成AIは「新しい画材」なのです。クリエイターからは、単純作業の効率アップに期待の声も上がっています。

古くはカメラの発明、最近ではデジタル化など、これまでも絵の制作には幾多の技術革新がありました。画像生成AIはそれらに続く「新しい画材」として、豊かなクリエイティビティに貢献していくでしょう。

変わることのない、言論の必要性

表現に関して、最後にもう一点指摘しておきましょう。テキスト(文章)の生成はどうなのか、という点です。

これについては、視点を新しいソフトウェアうんぬんではなく、「社会における言論の意義」にセットしてみましょう。すると、「言論」は人類が続く限り必要なものだということが見えてくるはずです。なぜなら、たとえ人工知能が人間並みの文章を生成できるようになったとしても、だから人はやらなくていいということにはならないからです。

たとえば、人工知能が「人種差別に反対する」内容の小説を作ったと仮定します。AIがすでにやったのだから、人間はもう人種差別に反対する必要はないのでしょうか? とんでもないですよね。

大事なことは、大事さに応じた量、世の中で語られるべきです。また、声を上げることで、自分を、そして周りの世界を変えられるということは、人間にとっていつの時代も変わらぬ真実です。人類社会における言論の必要性に、テクノロジーは関係ないのです。

結びに―テクノロジーの問題は、人間の問題

差別、冤罪、まちがった情報、世論の誘導や理性を欠いた投票、プライバシーの侵害や恐怖の監視社会、そして戦争。これらの問題点はすべて、AI以前から存在しています。新しい話など、一つたりともありません。

私が特に強調したいのは、センセーショナルな情報を流して人々を右往左往させているのは、ほかでもない人間であるということ。ここにAI機器は少しもかかわっていません。

自分の頭で考え、自分で決めることが大事だと言いました。しかし、これは新しいコンピュータープログラムが出てきたからそうなったのではありません。昔も今も将来も、主体性は人間にとって核心です。

人工知能の問題は、新しいテクノロジーにも反映された、人間の諸問題なのです。

私はもともとゲーム好きなので、コンピュータープログラムはずっと身近なものでした。インターネットには助けられ、大きな可能性を感じ、こうして今、自ら存分に活用しているくらいです。そういうわけでインターネットと関係の深い人工知能のことも自然と知るようになりました。だからこそ、地に足のつかない夢は見ない。根拠なき不安や恐怖も抱かない。あるがままの人工知能を見つめ、私たちの未来を考えているところです。

この記事で扱った各論題は、語り出したらきりがありません。本当は、あれについてもっと書きたい、これについて言及すべき、それについては例がほしい、個人的な実感も話したい……という部分が多々あるのですが、今回はここまで。冷静な頭で考え続け、新しい時代を一緒にすばらしいものにしていきましょう。

関連リンク

著者・日夏梢プロフィール||X(旧Twitter)|Mastodon|YouTube|OFUSE

主要参考資料・リンク

『マンガでわかる人工知能』三宅陽一郎監修、備前やすのり・マンガ(池田書店、2018年)

もし人工知能についてその道の専門家からきちんと学びたいなら、この一冊でいかがでしょうか。マンガで解説系の本だと内容は薄っぺらいのかな……なんていうのとは逆で、ちょうど我々が知りたかったことを網羅した良書です。ガマの油売り形式でもシロアリ駆除業者型でもなく、現実に立脚している点でも良書です。

『人工知能は人間を超えるか ディープラーニングの先にあるもの』松尾豊(KADOKAWA、2015年)– こちらも専門の研究者が、開発の歴史、可能となったこと・まだ実現していないこと、予測される問題などを解説した一般によく読まれている書です。

Rise of the racist robots – how AI is learning all our worst impulses – 「人種差別ロボット」を報じたガーディアン紙の記事です。

Face Value – 冤罪事件のスティーブン・タリ―さんへのインタビューが載っています。顔認識ソフトでは、制作者に悪意があったか否かは別としてこれまた人種差別が問題になることがあり、そのことも論じられています。

I Spy With My Digital Eye – ネットにつなぐとおしゃべりできるユニコーンのぬいぐるみの事件はこちら。

「Science vs Terrorism」 – フランスのBonne Pioche Televisionが2019年に制作した、密度の濃い良質なドキュメンタリーです。日本ではNHKが「BS世界のドキュメンタリー」で放送しました。AI兵器に直接携わっている特殊警察や軍人、大学や民間企業の懐に飛び込んで取材する姿勢はジャーナリズムの鏡です。

攻撃の最終判断、人間かAIか 「自律型」米中ロが開発急ぐ – 2020年6月20日の朝日新聞の記事です。兵器の開発状況や各国が計上している予算の額、倫理上の問題点や国際法規制のいまが報じられています。

【解説】Qアノン陰謀論とは何か、どこから来たのか 米大統領選への影響は – BBC日本語版による解説です。

AIに思い通りの絵を描かせられるのは誰だ! 「Midjourney」指示力選手権 – ITmedia NEWSの企画記事。「牛乳を注ぐ女」や「国境の長いトンネルを抜けると雪国であった」といったお題に沿って生成された絵の実物が見られます。

Adobe、画像生成AIを開発へ 倫理や法律面で“透明性”高めたクリエイターのためのツール目指す – ITmedia NEWSによるAdobeの発表を報じた記事です。

画像生成AIは悪なのか? マンガ家の端くれが思うこと – ITmedia NEWSに掲載された、マンガによる解説です。今後起こってきそうなトラブルや学習元データの問題などが、クリエイターの目線で網羅されています。

他、本文中外部リンク

当ブログ内の人工知能関連記事

私は他にも多くの人工知能にかかわる記事を書いてきました。今回論じたことを別の視点から見ることができるので、ぜひ併せてお読みください。

生成AIとは?―どこが問題点で、何が起こっているのか – 画像生成やChatGPT、Bardなどテキスト生成をめぐる問題点については、本稿内では長くなりすぎるので、単独で新しい記事にまとめました。本稿の続きのような記事なので、併せてお読みください。

インターネットからの個人情報流出事件解説と、自分でできる対策 – SNS史上最大最悪といわれるFacebookとデータ分析会社ケンブリッジ・アナリティカの事件を解説しました。トランプ大統領の誕生は、データ分析を駆使した心理操作の結果である――まるでSF映画を見すぎた人の白昼夢のようですが、これは現実です。私は近年で最も重要な事件だと考えているので、全容を徹底解説しました。

GAFA独占の問題点と日本の現状・課題 – Apple製品のSiriやGoogleアシスタント、AmazonのAlexaによる「会話盗み聞き」事件を解説しました。対応が早ければ早いほど、傷は浅くてすむもの。もしスマホ等の「AIアシスタント」を利用しているなら、青ざめるかもしれませんが必読です。

スマート家電(IoT家電)のメリットとデメリットー使ってみた感想とセキュリティ対策 – スマートスピーカーを使うことが「家の中に盗聴器を招き入れる」事態につながるケースなどを指摘し、セキュリティを固めるチェックポイントを解説しました。

5Gに危険性や悪影響?~人はなぜデマを作ってしまうのか – 会話AIを発展させると見込まれている5G通信環境について解説しました。その電波をめぐる科学的根拠のない流説がSNSで広まったことにも触れました。

『Qアノンの正体』徹底解説(ネタバレ有)~混乱はどこから生まれ、どう展開したのか – ネット上を舞台にアメリカ政治から世界へ広がった陰謀論ムーブメントを徹底解説した渾身の記事です。中心的な資料としたドキュメンタリー『Qアノンの正体』は全6話6時間におよぶ力作。関係者へのインタビューを見られる貴重な作品です。

YouTuberの行く末~問題とその後を解説 – YouTubeの「おすすめ」と自動再生では、陰謀論だけでなくヘイトスピーチへのめり込む例も多発しており、世界中で問題視されています。YouTube社が危険な動画をプログラムで自動で削除したところ、多くの投稿者が巻き添えをこうむった事件も紹介しました。

ポイントカード今昔:Tカードの個人情報第三者提供拒否ガイド付き – この記事で論じたプライバシーの問題点を、ポイントカードという別の視点から説明しました。最近、電子マネーやスマホ決済を便利だ便利だと持ち上げ、まるで「キャッシュレスは進んでいて現金払いするのは遅れている」かのように言い立てる者が現れていますが、読者の皆さんにはその裏事情がもう見えていると思います。大事な補足もあるので、併せてお読みください。

dポイントカードの使い方から解約まで―リンク付きまるごとガイド – 同じく国内で広く使われている共通ポイントカード・dカードについても、個人データの集積や、運営企業がデータを強く欲している様子を指摘し、個人情報の第三者提供を拒否する方法を解説しました。すぐに設定等ができるよう、手続きページへのリンクを貼ってあります。

ゼロからわかる!初音ミク・ボカロPとは&音楽制作の行方 – ヤマハが研究開発した音声合成技術・ボーカロイド(ボカロ)についてそもそも論から解説しました。それによってもたらされた音楽業界の変化についても解説、論評しています。

映画『2001年宇宙の旅』あらすじ・解釈・感想―人の個性は本当にいろいろ – 有名なSF映画で、超高性能コンピューター・HAL9000(通称・ハル)の「人間への反乱」が描かれています。そのストーリーや事実関係などを知りたい方はこちらの記事でどうぞ。

『2001年宇宙の旅』続編は理路整然!―映画『2010年』レビュー – 映画に関する記事だったので深入りはしなかったのですが、『2010年』が冷静に描いたAIと昨今氾濫する悪質な情報とを引き比べました。そしてあらためて「深入り」したのが今回の記事です。

純文学とエンタメ作品の定義と実情 – 人間が機械的に作り出す「コンテンツ=エンタメ作品の極」について解説してあります。プログラムによるアート生成について論じるなら、まずそもそもアートとは、というところから。

たまごっちスマート攻略情報・全10+NiziUキャラクター一覧 – 当ブログでは一部でゲーム情報を扱っているのですが、玩具メーカー・バンダイが人気シリーズ「たまごっち」でキャラクターに「声をかける」新機能を付けた際、あえてインターネットを利用した音声認識技術を使わず、ただ「音声を感知する」だけにとどめたことを紹介しました。

【更新履歴】

記事公開:2018年8月3日。プログラムの研究開発や導入が進み、状況が刻一刻と変わっていく性質上、本稿は加筆や修正の上で更新されることがあります。

2019年7月25日、冒頭の定義を加筆し、「購買:「おすすめ」の連鎖が生む、世にも不気味な現象」と「楽しい会話の相手は、AIキャラクターではない」の箇所を新たに書き下ろしました。

2019年12月31日、「「AIが再現した故人」は本人ではない―美空ひばりの歌声再現から」の箇所を新たに書き下ろしました。

2020年7月18日、「兵器―今すぐ国際的法規制が必要」の項のほとんどを新たに書き下ろしました。

2021年5月24日、「陰謀論:ごく普通だった人が豹変する、突然の悪夢」を書き下ろして画像を追加しました。

2021年9月23日、ボーカロイドに関する新記事を執筆したのに伴って、「『AIが再現した故人』は本人ではない―美空ひばりの歌声再現から」と該当箇所を再編集しました。

2022年1月14日、様々な業界で人工知能の開発や一部導入が進んだことに鑑み、「AI活用でうんと楽になる業界や職種」の項をすべて新たに書き下ろし、「仕事に活用してより楽に、より幸せに」の項を加筆しました。また、兵器の項を読みやすいよう再編集しました。

2022年10月27日、話題が盛り上がっているのを背景に「イラストレーターと画像生成AIの今後―メリットと課題」および「「新たな画材」としての画像生成AI」の項を新たに書き下ろしました。同11月2日、「機械学習に利用されている、ネット上の顔写真」の項を書き下ろしました。

2023年2月13日、「テキスト生成AIのいま―ChatGPTとGoogle Bard」の項全体を新たに書き下ろしました。

2023年5月23日、生成AIの問題点について別途記事を書き下ろしたのに伴い、本稿中で今後の課題を扱った項は重複になるためそちらの一部として移設しました。